O que é o LangFlow?

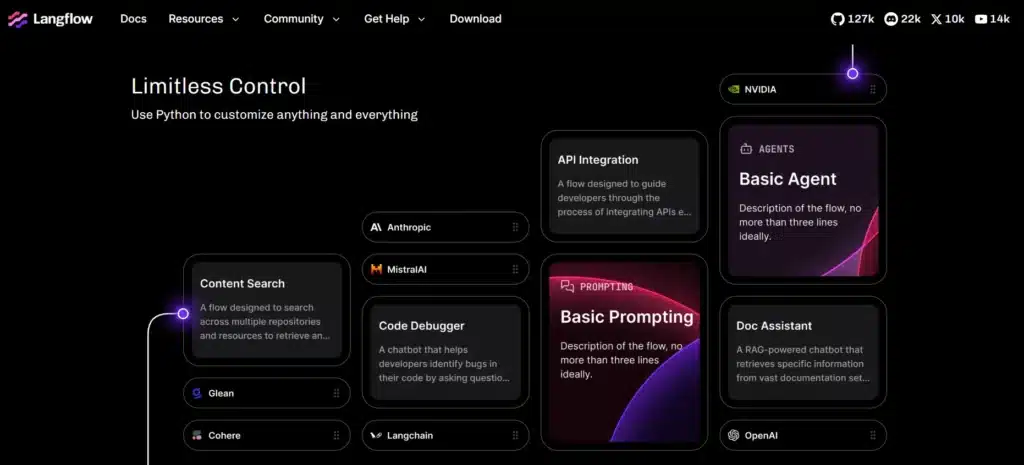

O LangFlow é uma plataforma open source com abordagem low-code que foi desenvolvida para facilitar a criação de agentes e aplicações de inteligência artificial baseadas em modelos de linguagem grandes (LLMs) como ChatGPT, Claude, LLaMA e outros do gênero. A ideia principal é oferecer uma interface visual bem intuitiva, onde você monta os fluxos de IA usando drag-and-drop (aquele famoso arrastar e soltar), o que elimina boa parte da necessidade de ficar programando do zero para tarefas mais comuns de IA conversacional e automação.

A interface gráfica é visual mesmo, no estilo que você vai ligando os componentes uns aos outros modelos de linguagem, bancos de dados vetoriais, APIs externas, sistemas de memória. Isso torna a experiência bem mais acessível tanto para quem está começando quanto para desenvolvedores que já têm mais experiência e querem prototipar rápido.

Embora seja no-code/low-code, o LangFlow não te prende num sistema fechado. Você pode integrar scripts Python direto na plataforma quando precisa criar componentes customizados ou processos mais avançados, então tem bastante flexibilidade para quem quer ir além dos blocos prontos que já vêm montados.

Por que usar o LangFlow?

Uma das principais vantagens do LangFlow é sua abordagem low-code, que democratiza o acesso à criação de aplicações de IA. Mas as vantagens não param por aí. Vamos explorar outros diferenciais do LangFlow.

Interface visual intuitiva com flexibilidade técnica real: o LangFlow consegue juntar duas coisas que normalmente não andam juntas: uma interface de arrastar e soltar superfácil de usar, mas que ao mesmo tempo não limita quem precisa de recursos mais avançados. Você pode começar simples e ir incrementando conforme necessário.

Integração nativa com LangChain, que é praticamente o padrão do mercado hoje: isso significa que você já tem acesso a um ecossistema maduro e testado, com componentes prontos para casos de uso comuns em IA conversacional e agentes inteligentes.

Versatilidade para diferentes casos de uso: dá para construir desde um chatbot simples até sistemas multiagentes complexos, passando por automação de tarefas internas, assistentes virtuais e prototipação rápida de ideias. A ferramenta cresce junto com o projeto.

Opções de deploy flexíveis, tanto local quanto em nuvem: você pode rodar localmente via Python, pip ou Docker quando precisar de controle total sobre dados sensíveis e privacidade, ou usar a versão gerenciada na nuvem para facilitar o escalonamento e manutenção. Essa escolha dá segurança para empresas que lidam com informações críticas.

Como instalar o LangFlow?

Antes de começar, você precisa ter o Python instalado na versão 3.10 até 3.13 (as versões mais recentes dentro dessa faixa funcionam bem). Além disso, é altamente recomendado criar um ambiente virtual para isolar a instalação e evitar aqueles conflitos chatos com outros pacotes Python que você já tem no sistema.

Passo a passo para instalar via Python

1. Abra o terminal ou prompt de comando no seu computador.

Depois ative o ambiente:

- No Windows:

.\nome_do_ambiente\Scripts\activate

- No Linux/MacOS:

source nome_do_ambiente/bin/activate

2. Agora instale o LangFlow rodando:

pip install langflow

3 Para iniciar a interface do LangFlow, você pode executar:

langflow

4. Pronto! O LangFlow vai abrir uma interface web local que normalmente fica acessível pelo navegador. O endereço aparece direto no terminal, mas geralmente é algo como http://localhost:7860.

Instalação via Docker

Se você prefere trabalhar com containers Docker (o que facilita bastante para quem já usa essa tecnologia),o procedimento é bem direto:

docker pull langflow/langflow

docker run -p 7860:7860 langflow/langflow

Isso vai iniciar o LangFlow na porta 7860, então você só precisa acessar http://localhost:7860 no navegador e começar a usar.

Containers: transformando o desenvolvimento em Python

Instalação via código fonte do GitHub

Para quem quer mexer no código ou usar versões de desenvolvimento mais recentes, dá para clonar o repositório oficial:

git clone https://github.com/langflow-ai/langflow.git

cd langflow

pip install -r requirements.txt

Esse método é ideal se você pretende contribuir com o projeto ou precisa testar funcionalidades que ainda não foram lançadas oficialmente. É um pouco mais trabalhoso, mas te dá controle total sobre o que está rodando.

GitHub: o que é, como funciona e como começar a usar

Criando seu primeiro fluxo no LangFlow

Vou te guiar passo a passo na criação do seu primeiro fluxo no LangFlow. Não se preocupe se você nunca usou a ferramenta antes, vou explicar cada etapa com detalhes para que você consiga acompanhar tranquilamente.

Passo 1: abrir a interface do LangFlow

Primeiro, você precisa iniciar o LangFlow no seu computador. Abra o terminal (ou prompt de comando no Windows) e digite:

langflow

Depois de rodar esse comando, o terminal vai mostrar algumas mensagens e, em algum momento, vai aparecer um endereço web, geralmente algo como http://localhost:7860. Copie esse endereço e cole no seu navegador (Chrome, Firefox, Edge, qualquer um serve).

Quando a página carregar, você verá a tela inicial do LangFlow. Procure pelo botão para criar um novo fluxo, que normalmente aparece como “New Flow” ou “Blank Flow” (Fluxo em Branco). Clique nele para começar do zero.

Passo 2: nomear e preparar o fluxo

Agora você está dentro do editor visual. A primeira coisa a fazer é dar um nome ao seu projeto, algo como “Meu Primeiro Fluxo LangFlow” ou “Chatbot Teste”. Isso ajuda a organizar quando você tiver vários fluxos salvos.

Você vai ver um espaço em branco no meio da tela (tipo uma tela de desenho) e, na lateral esquerda, uma barra com vários componentes disponíveis. Esses componentes são os blocos que você vai usar para montar seu fluxo, pense neles como peças de LEGO que se encaixam.

Passo 3: adicionar e configurar um modelo de linguagem (LLM)

Agora vem a parte legal. Na barra lateral, procure pela categoria “LLMs” ou “Models”. Ali você vai encontrar vários modelos de linguagem disponíveis, como OpenAI GPT-3.5, GPT-4, Claude, entre outros.

Para começar, vamos usar o OpenAI GPT-3.5 (que é mais barato e funciona bem para testes):

- Clique e arraste o componente “OpenAI” para a área de trabalho no centro da tela;

- Quando soltar, um bloco vai aparecer com o nome do modelo;

- Clique no bloco para abrir as configurações dele.

Aqui é onde você precisa configurar a chave de API da OpenAI. Se você ainda não tem uma:

- Acesse a plataforma OpenAI;

- Crie uma conta (se não tiver);

- Vá em “API Keys” e gere uma nova chave;

- Copie essa chave (ela parece algo como sk-proj-…).

Cole a chave no campo “OpenAI API Key” dentro das configurações do componente no LangFlow.

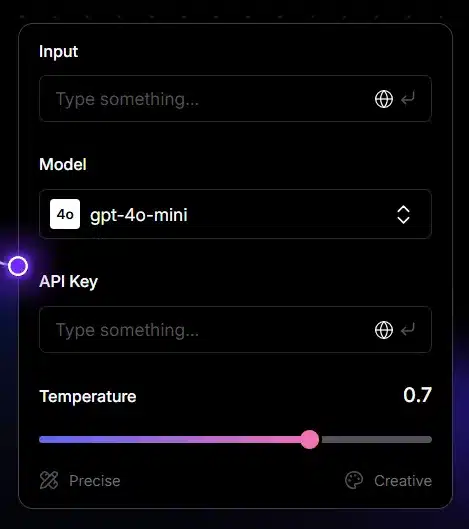

Ainda nas configurações, você vai ver um parâmetro chamado “Temperature” (Temperatura). Esse controla a criatividade das respostas:

- 0.0 a 0.3: respostas mais objetivas e previsíveis.

- 0.7 a 1.0: respostas mais criativas e variadas.

Para começar, deixe em 0.7 e clique em “Save” ou feche a janela de configurações.

Passo 4: adicionar um Prompt (instrução para o modelo)

Agora o modelo está configurado, mas ele precisa saber o que fazer. Para isso, vamos adicionar um Prompt Template.

- Na barra lateral, procure por “Prompts” ou “Prompt Template”;

- Arraste o componente “Prompt” para a área de trabalho;

- Clique nele para abrir as configurações.

Dentro do prompt, você vai escrever as instruções para o modelo. Por exemplo:

Você é um assistente útil e amigável. Responda às perguntas do usuário de forma clara e concisa.

Pergunta do usuário: {input}

Note o {input} – isso é uma variável que vai receber a pergunta do usuário automaticamente. Salve o prompt.

Agora você precisa conectar o Prompt ao modelo de linguagem:

- Clique no ponto de saída do bloco Prompt (geralmente um círculo na lateral direita);

- Arraste até o ponto de entrada do bloco OpenAI (círculo na lateral esquerda);

- Uma linha vai aparecer conectando os dois blocos.

Passo 5: adicionar um componente de entrada do usuário (Chat Input)

Para que você possa conversar com o fluxo, precisa de um lugar para digitar suas mensagens.

- Procure por “Chat Input” na barra lateral;

- Arraste para a área de trabalho;

- Conecte a saída do Chat Input à entrada do Prompt (onde está a variável {input}).

Passo 6: adicionar um componente de saída (Chat Output)

Agora precisamos de um lugar para mostrar as respostas do modelo.

- Procure por “Chat Output” na barra lateral;

- Arraste para a área de trabalho;

- Conecte a saída do bloco OpenAI à entrada do Chat Output.

Neste momento, seu fluxo deve ter essa estrutura básica: Chat Input → Prompt → OpenAI → Chat Output

Passo 7: testar o fluxo

Agora vem a hora da verdade! Vamos testar se tudo está funcionando.

- Procure pelo botão “Playground” ou “Run” no canto superior da tela;

- Clique nele uma janela de chat vai abrir na lateral direita;

- Digite uma mensagem de teste, tipo: “Olá, você pode me ajudar com Python?”;

- Aperte Enter e aguarde.

Se tudo estiver configurado corretamente, o modelo vai processar sua mensagem e retornar uma resposta.

Comparação do LangFlow com outras ferramentas de automação

Vou te ajudar a entender as diferenças entre essas plataformas e quando cada uma faz mais sentido. Todas trabalham com automação, mas têm focos bem diferentes.

LangFlow

O que ele faz de melhor:

O LangFlow foi feito especificamente para quem quer trabalhar com modelos de linguagem grandes (LLMs), então tem recursos bem voltados para isso. A interface visual permite montar fluxos complexos de IA sem programar tudo do zero, o que economiza bastante tempo.

Ele brilha quando você precisa de RAG (aquela técnica de recuperar informação de documentos externos), memórias conversacionais que mantêm o contexto entre interações e integração com vários provedores de IA ao mesmo tempo, tipo usar GPT da OpenAI numa parte do fluxo e Claude da Anthropic em outra. Por ser código aberto e extensível com Python, você pode customizar praticamente tudo quando os componentes prontos não são suficientes. É excelente para prototipagem rápida de ideias envolvendo IA.

Pontos negativos:

A curva de aprendizado pode ser um pouco íngreme para quem nunca mexeu com IA antes. Alguns usuários reclamam que certas funcionalidades organizacionais não são tão intuitivas quanto poderiam ser como gerenciar vários projetos ao mesmo tempo. Além disso, como qualquer software em desenvolvimento ativo, você pode encontrar bugs ocasionais. E tem outro detalhe: o LangFlow depende bastante do framework LangChain por baixo dos panos, então algumas limitações dessa base acabam afetando a plataforma também.

Quando escolher o LangFlow:

É a escolha certa quando seu projeto gira em torno de criar e orquestrar agentes inteligentes baseados em LLMs. Se você precisa montar fluxos de IA sofisticados com múltiplas etapas, recuperação de informações, memória contextual e tudo mais, o LangFlow é praticamente imbatível. Também é ideal se você quer flexibilidade para fazer customizações avançadas com código Python ou se prefere trabalhar com ferramentas open source que te dão controle total sobre o que está rolando.

Retool

O que ele faz de melhor:

O Retool é uma plataforma poderosa para construir dashboards internos e interfaces administrativas rapidinho. Ele tem suporte muito amplo para integrar APIs, bancos de dados relacionais, planilhas e praticamente qualquer fonte de dados empresarial que você imaginar. O foco dele está mais na automação de processos empresariais tradicionais e em criar ferramentas internas para equipes usarem.

Pontos negativos:

O problema é que o Retool não foi feito pensando em IA. Ele não tem recursos nativos para criar agentes, trabalhar com modelos de linguagem ou montar fluxos de IA conversacional. Até dá para integrar APIs de IA nele, mas você vai estar basicamente fazendo tudo na mão, sem os facilitadores que plataformas especializadas oferecem.

Quando NÃO escolher (em relação ao LangFlow):

Se o seu projeto é centrado em IA ou precisa de agentes LLM, o Retool não é a ferramenta certa. Ele brilha em outros cenários – tipo quando você quer construir um painel administrativo para gerenciar pedidos, visualizar métricas de vendas ou criar ferramentas internas para operações – mas para IA conversacional, melhor olhar para outras opções.

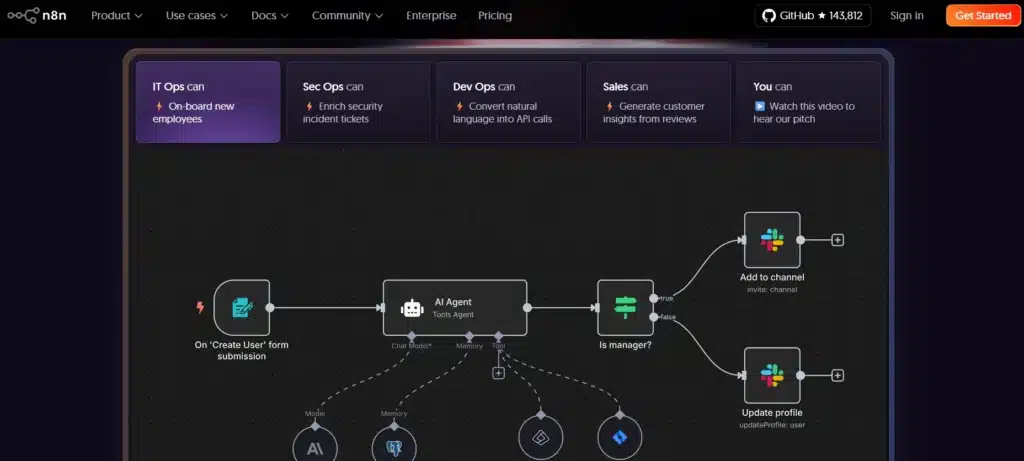

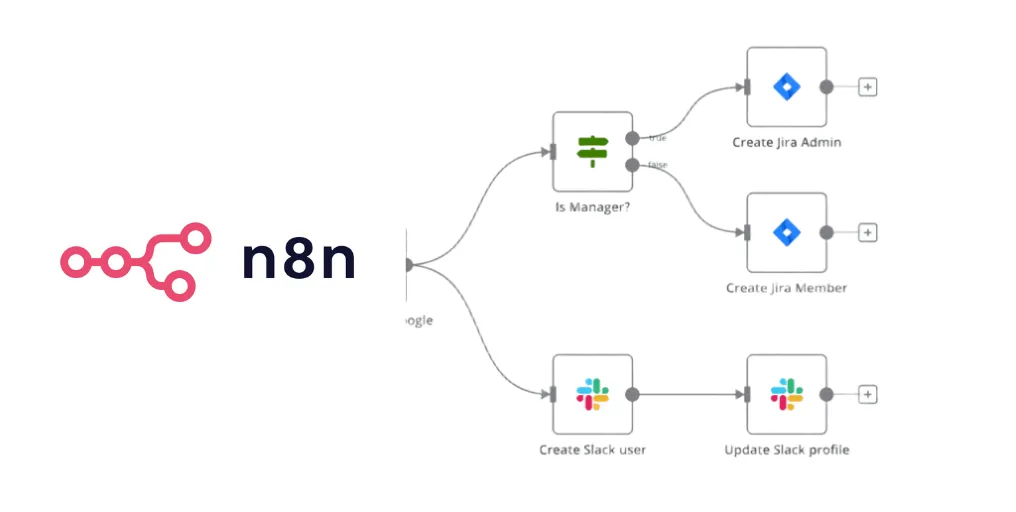

n8n

O que ele faz de melhor:

O n8n é superflexível e serve para automatizar workflows em geral, não necessariamente focados em IA. A interface visual é bem amigável e intuitiva, com um monte de integrações prontas (mais de 400, na verdade). Por ser open source, tem uma comunidade grande e ativa contribuindo com novos nodes e melhorias.

Você consegue orquestrar APIs diversas, conectar bancos de dados, agendar tarefas, enviar e-mails, postar em redes sociais, processar webhooks… praticamente qualquer tipo de automação que você imaginar. É excelente para integrar sistemas diferentes que precisam conversar entre si.

Pontos negativos:

Embora você possa adicionar IA nos workflows do n8n (ele tem nodes para OpenAI, por exemplo), os recursos específicos para inteligência artificial avançada são mais limitados. Não tem suporte nativo para agentes complexos, memórias conversacionais sofisticadas ou RAG da forma como o LangFlow oferece. O foco amplo dele significa que, para criar fluxos de IA especializados, você vai precisar de mais trabalho manual.

Quando escolher n8n em vez de LangFlow:

Se o seu foco é automação geral de processos empresariais do tipo “quando chegar um email com anexo, salvar no Google Drive e notificar no Slack”, o n8n é provavelmente melhor. Ele também é ótimo quando você precisa integrar várias APIs e serviços diferentes que não têm relação direta com IA. Pode até incluir elementos de IA no workflow, mas a prioridade não é essa.

O que é o n8n e como ele pode automatizar suas tarefas

Os melhores templates do n8n para automatizar suas tarefas

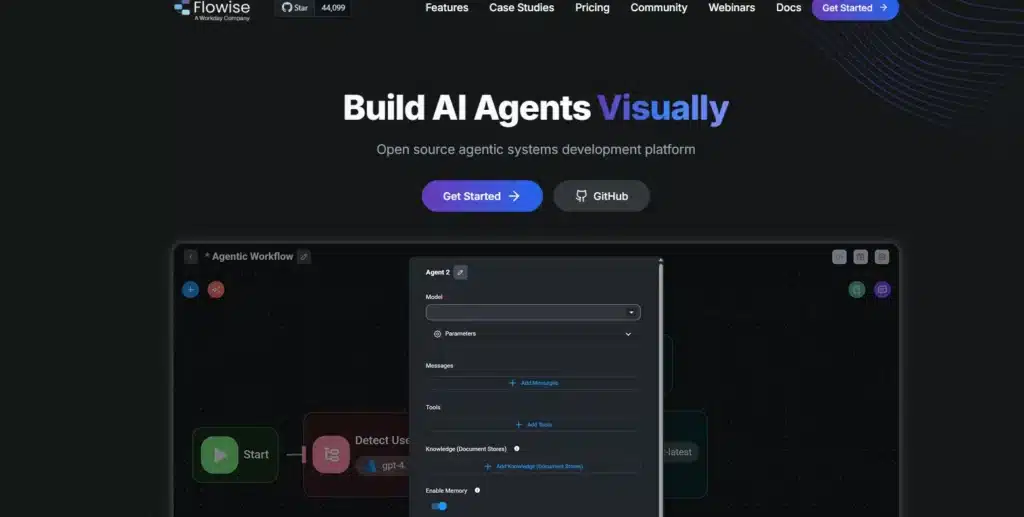

Flowise

O que ele faz de melhor:

O Flowise é bem similar ao LangFlow no propósito, pois foi feito especificamente para aplicações de IA e LLMs. A interface visual é bastante intuitiva, talvez até mais amigável para iniciantes que o LangFlow. Ele oferece templates prontos que facilitam começar rápido, tem integração fácil com armazenamento externo e vários serviços de IA.

Uma diferença técnica é que o Flowise usa NodeJS no backend (enquanto o LangFlow usa Python), o que pode ser relevante dependendo do seu stack tecnológico. A forma como ele organiza os fluxos (dividindo entre chatflows e agentflows) também é um pouco diferente.

Pontos negativos:

Para usuários mais avançados que querem fazer customizações profundas, o Flowise pode ser menos potente que o LangFlow. A divisão entre chatflows e agentflows, embora faça sentido conceitualmente, pode confundir um pouco no começo. Além disso, as opções de exportação dos fluxos são mais limitadas, você não tem tanta flexibilidade para pegar seu trabalho e usar em outros contextos.

Quando escolher Flowise em vez de LangFlow:

Se você está começando e quer uma interface mais amigável com configuração rápida, o Flowise pode ser a melhor pedida. É excelente para prototipagem e projetos que não precisam de customização muito profunda via código. Mas, se você prevê que vai precisar de controle técnico avançado ou quer escrever componentes customizados em Python, o LangFlow acaba sendo mais apropriado.

Tabela resumida de comparação

| Plataforma | Melhor para | Evite se você precisa de |

| LangFlow | Agentes de IA avançados, fluxos com LLMs, RAG, memória conversacional, customização com Python | Automação empresarial tradicional sem IA |

| Retool | Dashboards internos, ferramentas administrativas, integração de dados empresariais | Agentes de IA, workflows conversacionais com LLMs |

| n8n | Automação geral, integração de APIs diversas, workflows empresariais variados | Fluxos de IA complexos com agentes e memória |

| Flowise | Prototipagem rápida de IA, interface amigável para iniciantes, chatbots simples | Customizações profundas em Python, controle técnico avançado |

Quer ir além e dominar de verdade as aplicações de IA?

Se você curtiu aprender sobre o LangFlow e quer continuar sua jornada no mundo da inteligência artificial, temos algo especial para você. A Trilha Aplicações IA: Explorando modelos, plataformas e projetos de IA, da Asimov Academy, foi criada justamente para quem quer construir aplicações práticas e reais com IA.

Na trilha, você vai aprender a integrar diferentes inteligências artificiais com Python – desde OpenAI e Hugging Face até modelos locais rodando no seu próprio computador. Tudo isso através de projetos objetivos como criação de chatbots, transcrição de áudios, geração de imagens, simulação de agentes inteligentes e até a construção de um sistema de busca inspirado no Perplexity AI.

O que você vai encontrar na trilha:

- Fundamentos sólidos de programação em Python para IA;

- Engenharia de Prompts para conversar estrategicamente com IAs;

- API da OpenAI (ChatGPT, DALL·E, Whisper, GPT-Vision);

- Hugging Face e acesso a mais de 500 mil modelos prontos;

- Modelos alternativos como Claude, Gemini e DeepSeek;

- Como rodar modelos de IA localmente, sem depender da internet;

- Criação de interfaces com Streamlit para suas aplicações;

- Projetos práticos guiados baseados em situações reais.

Trilha Aplicações IA com Python

Crie agentes autônomos combinando modelos de linguagem (como ChatGPT, DeepSeek e Claude) com Python.

Comece agora

Cursos de programação gratuitos com certificado

Aprenda a programar e desenvolva soluções para o seu trabalho com Python para alcançar novas oportunidades profissionais. Aqui na Asimov você encontra:

- Conteúdos gratuitos

- Projetos práticos

- Certificados

- +20 mil alunos e comunidade exclusiva

- Materiais didáticos e download de código

Comentários

30xp