Lovable: IA cria sites e aplicativos sem precisar programar

Por que a inteligência artificial avançou tanto nos últimos anos?

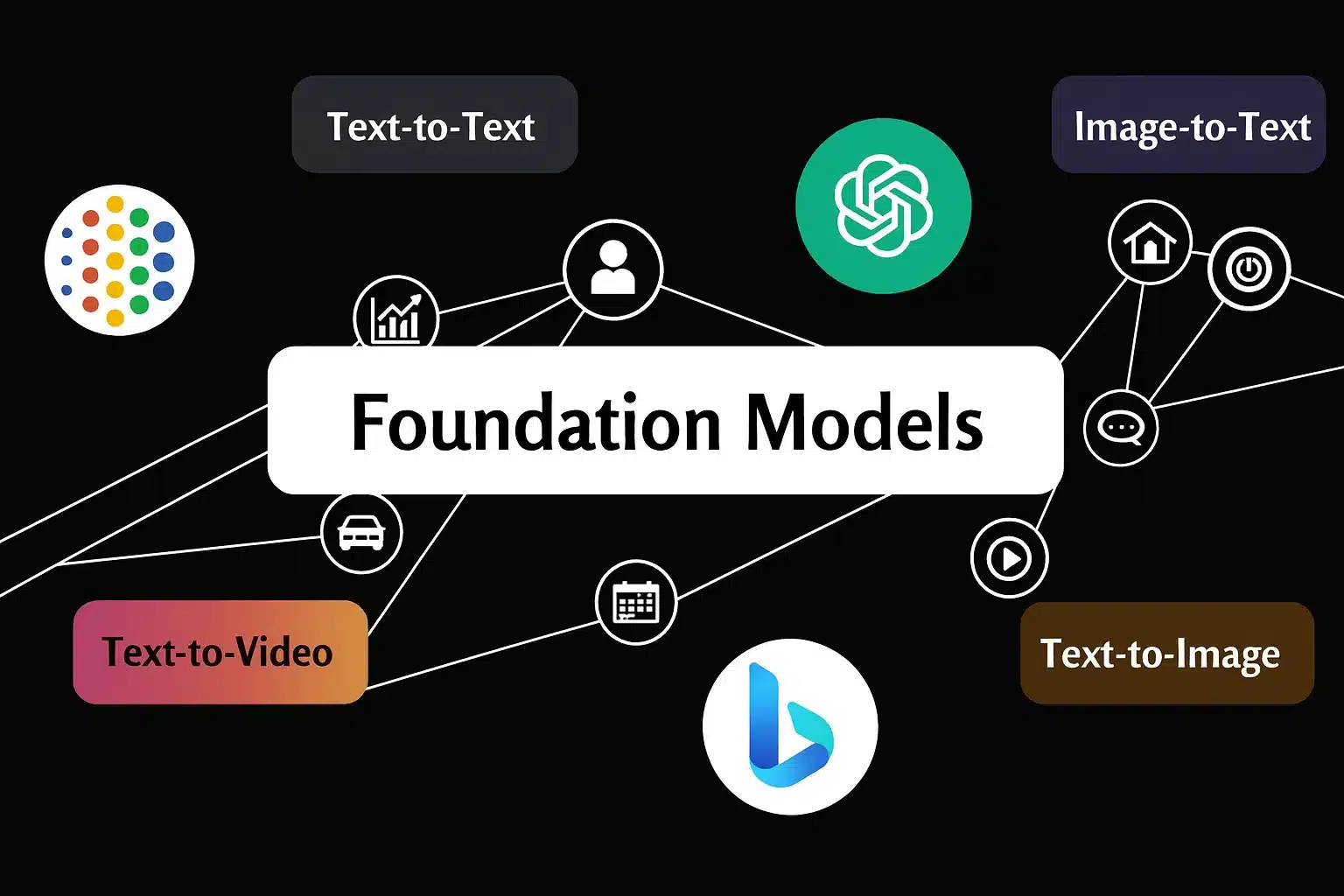

Se você já se fez essa pergunta ao ver ferramentas como ChatGPT, GitHub, Copilot ou Midjourney em ação, saiba que a resposta está nos foundation models, modelos de IA de grande escala que servem como base para uma nova geração de aplicações inteligentes.

Esses modelos estão por trás de soluções capazes de gerar textos, interpretar imagens, compreender comandos de voz e até escrever códigos com apenas alguns exemplos.

Neste artigo, você vai entender o que são os foundation models, como funcionam e por que eles estão revolucionando o desenvolvimento de inteligência artificial em diversos setores.

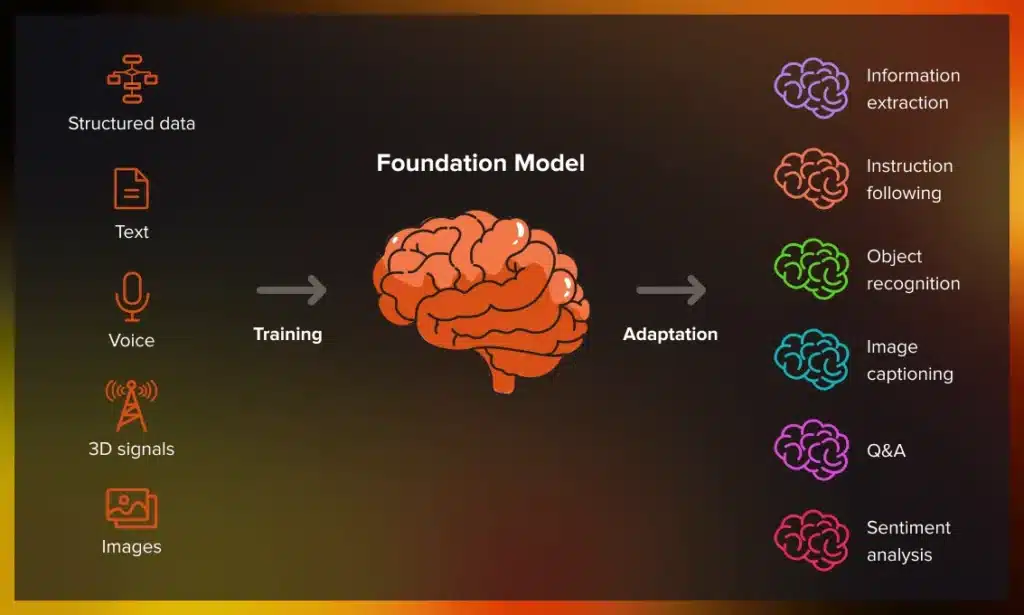

Foundation Models são modelos de inteligência artificial (IA) de grande escala, pré-treinados com quantidades massivas de dados não rotulados, como textos, imagens, áudios e vídeos geralmente, por meio de aprendizado não supervisionado ou autossupervisionado. Nesse contexto, esses modelos utilizam arquiteturas avançadas, como os Transformers, capazes de capturar padrões complexos e relações em grandes volumes de dados.

O termo foundation (fundação) é utilizado porque esses modelos funcionam como uma base versátil para diversas aplicações de IA. Após o pré-treinamento, podem ser adaptados seja por fine-tuning, seja por prompt engineering (engenharia de prompt) para executar uma ampla variedade de tarefas específicas. Entre essas tarefas, destacam-se geração de texto, tradução, classificação, resposta a perguntas e criação de imagens, entre outras. Como resultado, exigem apenas uma quantidade mínima de dados adicionais para se ajustarem a novos contextos.

Além disso, essa capacidade de adaptação é justamente o que diferencia os foundation models dos modelos tradicionais, os quais, por sua vez, são desenvolvidos para finalidades específicas e limitadas. Enquanto os modelos antigos se assemelham a ferramentas fixas, os foundation models funcionam como plataformas multifuncionais.

Para que você possa entender melhor, vamos comparar os foundation models a um cérebro treinado com uma grande variedade de conhecimentos. Assim como um cérebro pode se adaptar a diferentes tarefas com pequenas instruções, os foundation models também operam em diversos contextos com ajustes mínimos.

Entre algumas característica elas, destacam-se:

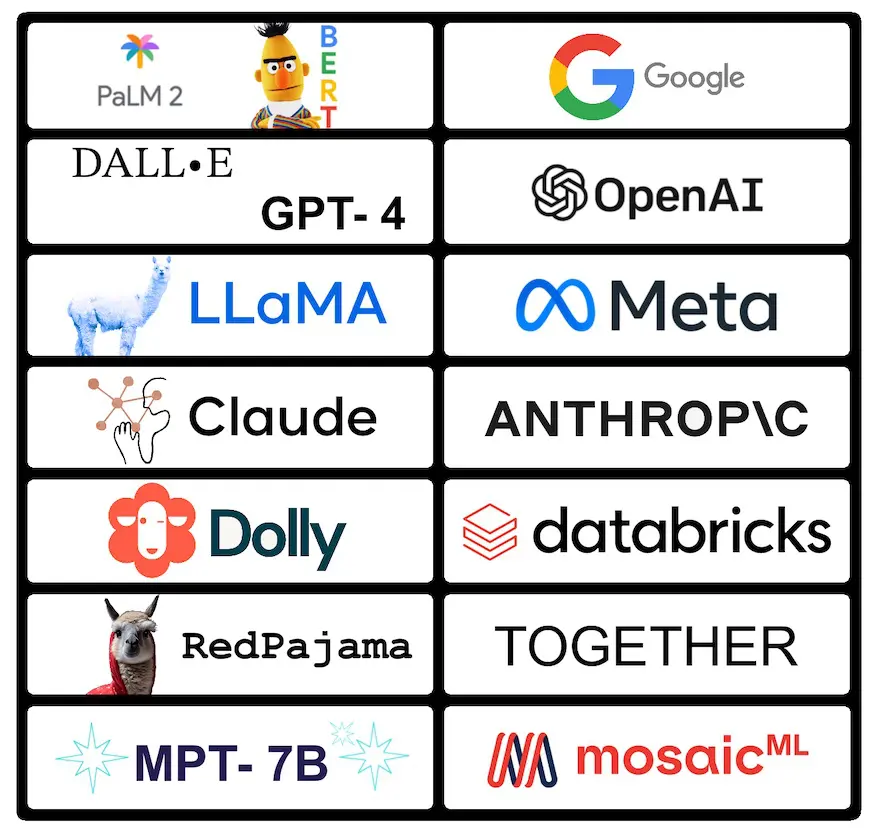

Atualmente, diversos foundation models se destacam por sua aplicação em tarefas complexas de IA. A seguir, apresento os exemplos mais relevantes:

| Modelo | Desenvolvedor | Aplicações principais |

| GPT (Generative Pre-trained Transformer) | OpenAI | Modelo de linguagem natural utilizado no ChatGPT para geração de texto, respostas, tradução, criação de código, entre outras tarefas de NLP. Versões notáveis incluem GPT-2, GPT-3 e GPT-4. |

| BERT (Bidirectional Encoder Representations from Transformers) | Modelo bidirecional empregado em mecanismos de busca, análise de sentimentos, classificação de texto e resposta a perguntas. | |

| CLIP (Contrastive Language–Image Pre-training) | OpenAI | Integra visão computacional e linguagem natural, permitindo associar imagens a descrições textuais, sendo ideal para tarefas multimodais. |

| Stable Diffusion | Comunidade / diversas organizações | Modelo generativo voltado à criação de imagens realistas com base em descrições em linguagem natural. |

| Whisper | OpenAI | Modelo voltado ao reconhecimento automático de voz, transcrição e tradução de áudio. |

| DALL·E 2 | OpenAI | Focado na geração de imagens a partir de texto, amplamente utilizado em criações artísticas e ilustrações. |

| LaMDA | Desenvolvido para diálogos conversacionais avançados, com foco em interações naturais e contextuais. | |

| Codex | OpenAI | Especializado em geração de código. Além disso, é a base do GitHub Copilot para sugerir códigos em tempo real. |

| BLOOM | Hugging Face e comunidade | Modelo multilingue treinado em 46 idiomas e 13 linguagens de programação, voltado a diversas tarefas de NLP. |

| LLaMA | Meta | Direcionado à pesquisa e ao desenvolvimento em IA, com foco em eficiência computacional e adaptabilidade. |

Os foundation models estão transformando a inteligência artificial por uma série de razões fundamentais. Em primeiro lugar, promovem uma redução drástica no tempo necessário para criar soluções inteligentes. Isso porque, ao serem pré-treinados com grandes volumes de dados, eliminam a necessidade de iniciar o treinamento do zero a cada nova aplicação, o que acelera significativamente o desenvolvimento de sistemas de IA eficientes.

Além disso, contribuem para a democratização do uso da inteligência artificial, já que muitos desses modelos estão disponíveis por meio de APIs e bibliotecas em Python. Como resultado, empresas e desenvolvedores com recursos limitados tanto técnicos quanto computacionais conseguem integrar IA avançada em seus produtos e serviços, ampliando o acesso à tecnologia de ponta.

Outro fator relevante é a possibilidade de criar MVPs (produtos mínimos viáveis) com rapidez e alto valor agregado. Por serem versáteis, os foundation models podem ser facilmente adaptados por meio de técnicas como fine-tuning.

Esses modelos representam uma verdadeira mudança de paradigma na construção de sistemas de IA. Isso ocorre porque sua capacidade de generalização e transferência de conhecimento permite que um único modelo sirva como base para múltiplas aplicações, reduzindo custos e otimizando esforços de desenvolvimento.

No entanto, é importante reconhecer que essa revolução também traz desafios significativos. Entre eles, destacam-se a necessidade de garantir transparência, mitigar tendência algorítmicas e enfrentar questões éticas, temas que vêm sendo amplamente debatidos por centros de pesquisa especializados.

Os foundation models estão mudando a IA porque aceleram o desenvolvimento de soluções, ampliam o acesso à tecnologia e tornam a inteligência artificial mais prática, acessível e escalável, características essenciais para sua adoção ampla e responsável.

Para entender melhor a evolução dos foundation models e como eles tornaram o desenvolvimento de IAs mais acessível, confira o vídeo a seguir.

Atualmente, é possível utilizar foundation models com Python de forma prática e eficiente. Para isso, diversas bibliotecas e plataformas foram desenvolvidas com o objetivo de facilitar o acesso, a adaptação e a aplicação desses modelos em diferentes tarefas de inteligência artificial. A seguir, apresento as principais ferramentas disponíveis:

A seguir, veja alguns exemplos de uso direto dessas bibliotecas:

from openai import OpenAI

client = OpenAI()

response = client.chat.completions.create(

model="gpt-4o-mini",

messages=[{"role": "user", "content": "Olá, como posso ajudar?"}]

)

print(response.choices[0].message.content)from transformers import pipeline

summarizer = pipeline("summarization", model="facebook/bart-large-cnn")

text = "Texto longo para resumir..."

summary = summarizer(text, max_length=100, min_length=30, do_sample=False)

print(summary[0]['summary_text'])from transformers import pipeline

sentiment_analyzer = pipeline("sentiment-analysis")

result = sentiment_analyzer("Eu adoro usar foundation models!")

print(result)from langchain.chat_models import ChatOpenAI

from langchain.chains import LLMChain

from langchain.prompts import PromptTemplate

llm = ChatOpenAI(model_name="gpt-4o")

prompt = PromptTemplate(

input_variables=["tema"],

template="Explique os benefícios dos foundation models no contexto de: {tema}"

)

chain = LLMChain(llm=llm, prompt=prompt)

resposta = chain.run(tema="educação")

print(resposta)Além das bibliotecas específicas para foundation models, vale mencionar algumas ferramentas fundamentais no ecossistema Python.

Entre elas, destacam-se PyTorch e TensorFlow, essenciais para construção, treinamento e personalização de modelos de deep learning. Por outro lado, bibliotecas como Scikit-learn, Pandas e NumPy desempenham papel importantíssimo no pré-processamento e na análise de dados.

Foundation Models:

A principal diferença entre os foundation models e os modelos tradicionais de machine learning está na escala, na capacidade de generalização e na flexibilidade de aplicação.

Machine learning:

Enquanto os modelos clássicos costumam ser desenvolvidos para tarefas bem definidas e com escopo restrito, os foundation models operam de forma mais ampla, com potencial para múltiplas aplicações a partir de um único pré-treinamento.

Foundation models:

Para começar, os foundation models são treinados com volumes massivos de dados não estruturados e não rotulados, incluindo texto, imagens, áudios e até códigos, o que resulta em arquiteturas com bilhões ou até trilhões de parâmetros. Como exemplo, estima-se que o GPT-4 tenha centenas de bilhões de parâmetros, embora os valores exatos não tenham sido oficialmente divulgados.

Machine learning:

Em contrapartida, os modelos tradicionais utilizam conjuntos de dados menores e mais específicos, geralmente estruturados e rotulados, o que limita sua escalabilidade e capacidade de adaptação.

Foundation models

Além disso, os foundation models são altamente generalistas. Isso significa que, após o pré-treinamento, conseguem desempenhar diversas tarefas com apenas pequenos ajustes por fine-tuning ou engenharia de prompts.

Machine learning:

Já os modelos tradicionais precisam ser treinados do zero para cada novo problema, o que implica o uso de dados rotulados e um esforço considerável para cada aplicação.

Foundation models:

Os foundation models, em sua maioria, são baseados em redes neurais profundas, especialmente os Transformers, que oferecem grande poder de representação e flexibilidade.

Machine leaning:

Por outro lado, os modelos tradicionais utilizam algoritmos mais simples, como regressão logística, SVM, árvores de decisão, Random Forest ou boosting, cada um mais adequado a uma tarefa específica, como classificação, regressão ou agrupamento.

Ainda nesse contexto, a flexibilidade e a reutilização se destacam como grandes vantagens dos foundation models. Afinal, eles podem ser reaproveitados em diferentes domínios e contextos, reduzindo significativamente o tempo e os custos de desenvolvimento.

Já os modelos tradicionais, por serem construídos sob medida para tarefas específicas, apresentam baixa possibilidade de reaproveitamento direto, o que limita sua aplicação e exige treinamentos individuais para cada nova tarefa.

A flexibilidade dos foundation models não só acelera o desenvolvimento, como também amplia a aplicabilidade e aumenta a eficiência na criação de soluções inteligentes.

Os foundation models representam uma virada de chave na forma como desenvolvemos e aplicamos inteligência artificial. Por serem altamente generalistas, reutilizáveis e acessíveis por meio de bibliotecas e APIs, eles permitem que qualquer pessoa, mesmo sem ser especialista em IA, possa construir soluções reais e poderosas com pouco código.

Se você quer aprender a usar foundation models com Python para criar chatbots, gerar resumos, automatizar tarefas ou desenvolver projetos com IA de verdade, mesmo sendo iniciante, a dica é:

Explore a TrilhaAplicações IA com Python

Essa trilha é ideal para quem quer sair do zero e aplicar IA na prática, com exemplos guiados, projetos e ferramentas modernas. Aproveite!

Crie agentes autônomos combinando modelos de linguagem (como ChatGPT, DeepSeek e Claude) com Python.

Comece agora

Aprenda a programar e desenvolva soluções para o seu trabalho com Python para alcançar novas oportunidades profissionais. Aqui na Asimov você encontra:

Comentários

30xp