As bibliotecas de Python para web scraping são conjuntos de ferramentas e funções prontas que facilitam a extração de dados de páginas da web. Em vez de escrever toda a lógica do zero, você aproveita métodos já disponíveis para acessar sites, interpretar o HTML e capturar as informações necessárias.

Neste artigo, você vai conhecer as principais bibliotecas de Python web scraping, descobrir como escolher a ferramenta ideal para o seu projeto e conferir exemplos práticos de aplicação.

Python se tornou a linguagem preferida para web scraping, principalmente pela força de suas bibliotecas. Elas entregam três grandes vantagens:

- Simplicidade: a sintaxe clara e legível do Python, somada a bibliotecas bem estruturadas, permite que até iniciantes criem scripts eficazes em poucas linhas de código;

- Comunidade ativa: Python possui uma das maiores comunidades de desenvolvedores do mundo. Isso garante tutoriais, fóruns e exemplos de código aberto para resolver qualquer desafio;

- Integração com dados: se conectam facilmente a ferramentas como Pandas, NumPy e Matplotlib, permitindo limpar, analisar e visualizar os dados logo após a extração.

Bibliotecas para Web Scraping em Python: Vantagens e Diferenças

Principais bibliotecas de Python para web scraping

Existem várias bibliotecas em Python que podem ser utilizadas para web scraping, cada uma com suas particularidades e vantagens. Conheça as mais usadas a seguir:

1. Beautiful Soup

O Beautiful Soup é uma biblioteca projetada para analisar (fazer o parsing) de documentos HTML e XML.

Na prática, ele pega o código de uma página e o transforma em uma árvore de objetos Python, que você pode percorrer e manipular de forma muito mais simples do que trabalhar diretamente com strings de HTML.

Assim, em vez de procurar manualmente trechos de código com expressões regulares, você pode usar métodos prontos como find e find_all para localizar elementos por tag, classe, ID ou atributos específicos.

Por que usar o Beautiful Soup?

- Simplicidade: API intuitiva, com métodos fáceis de lembrar;

- Robustez: lida bem até com HTML malformatado, algo comum na web;

- Flexibilidade: funciona com diferentes parsers, como lxml (mais rápido) ou html.parser (padrão do Python);

- Integração: geralmente usado em conjunto com o Requests, que faz o download do HTML.

Como Utilizar Beautiful Soup para Web Scraping

Quando usar Beautiful Soup?

- Em projetos que envolvem sites estáticos;

- Quando você precisa extrair dados de páginas complexas, mas com HTML bem estruturado;

- Quando você é iniciante e está dando os primeiros passos no web scraping.

Pontos fortes

- API simples e intuitiva;

- Suporte a diferentes parsers;

- Comunidade ativa e documentação completa;

- Integração eficiente com Requests.

Limitações

- Não executa JavaScript;

- Pode ser menos eficiente em páginas muito grandes ou quando a performance é um fator importante.

Como Localizar Elementos de uma Página Web com Beautiful Soup

Exemplo de extração de dados com Beautiful Soup

from bs4 import BeautifulSoup

# HTML fictício (poderia ser baixado com requests)

html = """

<html>

<head><title>Minha Loja</title></head>

<body>

<h1>Produtos</h1>

<ul>

<li class="item">Notebook</li>

<li class="item">Smartphone</li>

<li class="item">Fone de Ouvido</li>

</ul>

</body>

</html>

"""

# Criar objeto BeautifulSoup

soup = BeautifulSoup(html, 'html.parser')

# Extrair o título da página

print("Título da página:", soup.title.text)

# Encontrar todos os itens da lista

items = soup.find_all('li', class_='item')

# Mostrar os nomes dos produtos

for item in items:

print("Produto:", item.text)Saída esperada:

Título da página: Minha Loja

Produto: Notebook

Produto: Smartphone

Produto: Fone de OuvidoO que esse código mostra?

Nesse exemplo, criamos uma string com código HTML simulando uma página simples. Em um caso real, esse HTML seria obtido com o Requests. O Beautiful Soup analisa o documento e o transforma em uma árvore de objetos Python, facilitando a navegação.

O código:

- Lê um documento HTML simples (com título e lista de produtos);

- Extrai o título da página (

Minha Loja); - Localiza todos os elementos

<li>com a classeitem; - Percorre esses elementos e imprime o nome de cada produto.

2. Selenium

Selenium é a biblioteca de Python mais popular para automação de navegadores e uma das melhores opções para web scraping em sites dinâmicos (aqueles que usam muito JavaScript).

Diferentemente de ferramentas como o Beautiful Soup, o Selenium não apenas lê o HTML: ele controla um navegador real, simulando ações humanas, como:

- Clicar em botões;

- Preencher formulários;

- Rolar a página para carregar mais conteúdo;

- Navegar entre links.

Essa flexibilidade faz dele uma ótima escolha para extrair dados de páginas que exibem informações apenas após interações do usuário.

Principais características

- Automação completa do navegador;

- Suporte a vários navegadores: Chrome, Firefox, Edge, Safari e Opera;

- Modo headless: executa o scraping sem abrir a janela do navegador;

- Capacidade de executar JavaScript diretamente;

- Compatível com várias linguagens além de Python (Java, Ruby, Node.js, etc.).

Selenium com Python: tutorial completo para automação

Quando usar o Selenium?

- Em sites dinâmicos, onde o conteúdo só aparece após interação;

- Para lidar com rolagem infinita, como em e-commerces que carregam produtos ao descer a página;

- Em páginas que exigem login ou preenchimento de formulários antes de liberar os dados;

- Sempre que for necessário simular ações reais de um usuário.

Pontos fortes

- Funciona bem com JavaScript pesado;

- Capaz de simular interações complexas;

- Suporte multiplataforma e múltiplos navegadores.

Limitações

- Mais lento do que bibliotecas de scraping puro;

- Consome mais recursos do sistema;

- Exige configuração adicional (instalação do WebDriver).

Guia Básico de Selenium com Python

Exemplo: abrir página e clicar em botão com Selenium

from selenium import webdriver

from selenium.webdriver.common.by import By

import time

# Inicia o navegador (certifique-se de ter o ChromeDriver instalado)

driver = webdriver.Chrome()

driver.get("https://example.com")

# Encontra e clica no botão "Carregar mais"

load_more_button = driver.find_element(By.ID, "load-more-btn")

load_more_button.click()

# Aguarda o carregamento do novo conteúdo

time.sleep(3)

# Coleta os itens da página

items = driver.find_elements(By.CSS_SELECTOR, ".item-class")

for item in items:

print(item.text)

# Fecha o navegador

driver.quit()O que esse código mostra?

Esse exemplo demonstra como o Selenium pode automatizar um navegador para coletar dados de um site dinâmico:

driver.get("https://example.com"): inicia o navegador (neste caso, o Chrome) e acessa a página indicada;find_element(By.ID, "load-more-btn"): localiza o botão “Carregar mais” e simula um clique, como um usuário faria;time.sleep(3): aguarda alguns segundos para que o novo conteúdo seja carregado;find_elements(By.CSS_SELECTOR, ".item-class"): busca todos os elementos com a classe.item-classe imprime seus textos;driver.quit(): encerra o navegador ao final do processo.

3. Requests

Requests é a biblioteca mais popular de Python para trabalhar com requisições HTTP. Ele simplifica a comunicação entre o Python e a web, permitindo buscar ou enviar dados de forma rápida e intuitiva.

Com poucas linhas de código, você consegue acessar uma página, capturar o HTML e usá-lo junto a outras bibliotecas, como o Beautiful Soup, para analisar e extrair informações.

Principais características

- API simples e fácil de usar;

- Suporte a todos os métodos HTTP (

GET,POST,PUT,DELETEetc.); - Gerenciamento de sessões, cookies e autenticação;

- Configuração simples de cabeçalhos, parâmetros e proxies;

- Integração nativa com SSL e tratamento de erros.

Requests Python: como fazer requisições HTTP de forma simples e prática

Quando usar o Requests?

- Em sites estáticos, onde o conteúdo já está no HTML;

- Para consumir APIs REST e manipular dados em JSON;

- Em tarefas simples de scraping, quando não é necessário rodar JavaScript ou interagir com elementos da página.

Pontos fortes

- Rápido, leve e fácil de aprender;

- Excelente para iniciantes;

- Documentação completa e comunidade ativa;

- Integração prática com bibliotecas como Beautiful Soup.

Limitações

- Não funciona bem em páginas com muito JavaScript;

- Não possui recursos de parsing nativos (precisa ser combinado com outra biblioteca);

- Não tem suporte assíncrono integrado.

Exemplo de requisição simples com Requests

import requests

response = requests.get("https://www.example.com")

if response.status_code == 200:

print(response.text) # imprime o HTML da página

else:

print("Falha ao acessar a página")O que esse código mostra?

Esse exemplo usa a biblioteca Requests para acessar uma página da web:

requests.get(...)envia uma requisição HTTP para a URL indicada;- A resposta fica armazenada em

response, que contém o status e o conteúdo da página; - O

if response.status_code == 200verifica se a requisição foi bem-sucedida (status200significa OK); - Se deu certo, o programa imprime todo o HTML retornado;

- Caso contrário, exibe a mensagem “Falha ao acessar a página”.

APIs para iniciantes – HTTP, Requests e APIs com Python

4. Pandas (com read_html)

O Pandas é conhecido como a principal biblioteca de manipulação e análise de dados em Python, mas também pode ser usado em tarefas de web scraping. Isso é possível graças à função read_html, que captura tabelas diretamente de uma página e as transforma em DataFrames prontos para análise.

Como funciona?

- O

read_htmlidentifica automaticamente os elementos HTML de uma tabela (<table>,<tr>,<th>,<td>); - Cada tabela encontrada é convertida em um DataFrame;

- A partir daí, você pode limpar, transformar e analisar os dados usando os recursos do Pandas.

Importante: a função só funciona quando a tabela está realmente no HTML. Se for uma imagem (<img>), não tem como extrair.

Pandas Python: Como usar a ferramenta #1 de análise de dados

Principais características

- Captura automática de tabelas HTML: transforma direto em DataFrames;

- Integração nativa: já retorna os dados no formato ideal para análise;

- Facilidade de uso: uma única linha de código (

pd.read_html(url)) extrai todas as tabelas de uma página; - Limpeza e transformação: permite tratar valores ausentes, renomear colunas e reorganizar dados;

- Exportação simples: salve os dados em CSV, Excel ou até bancos de dados SQL;

- Versatilidade: ideal quando a página contém tabelas bem estruturadas.

Quando usar o Pandas para scraping?

- Quando você precisa extrair dados tabulares diretamente do HTML;

- Para análises rápidas, sem precisar usar parsers manuais;

- Em cenários onde o foco está mais na análise dos dados do que no scraping em si.

Pontos fortes

- Integração direta com a análise de dados;

- Simplicidade: uma única linha já captura a tabela;

- Conversão automática para DataFrames.

Limitações

- Só funciona com tabelas HTML estruturadas;

- Não lida com sites dinâmicos que carregam conteúdo via JavaScript;

- Pode exigir limpeza extra se a tabela tiver formatações complexas.

Analisando Dados com Pandas & SQL

Exemplo prático com Pandas

import pandas as pd

url = "https://www.fdic.gov/resources/resolutions/bank-failures/failed-bank-list/"

tables = pd.read_html(url) # retorna uma lista de DataFrames

# Seleciona a primeira tabela encontrada

df = tables[0]

print(df.head()) # mostra as primeiras linhasO que esse código mostra?

Esse exemplo usa o Pandas para extrair tabelas diretamente de uma página da web:

pd.read_html(url)acessa a URL e identifica todos os elementos<table>no HTML;- O resultado é uma lista de DataFrames, já que a página pode ter várias tabelas;

tables[0]seleciona a primeira tabela encontrada;df.head()imprime as primeiras linhas, facilitando a visualização inicial dos dados.

Ou seja, esse código mostra como é simples capturar uma tabela HTML e transformá-la em um DataFrame pronto para análise com o Pandas.

Como escolher a biblioteca certa para cada projeto?

A escolha da biblioteca ideal depende totalmente do contexto do seu projeto. Para decidir, responda a estas perguntas:

O site é estático ou dinâmico?

- Estático (conteúdo já vem no HTML): use Requests + Beautiful Soup;

- Dinâmico (dados carregados via JavaScript, scroll infinito, botões, etc.): use Selenium.

Você precisa interagir com a página?

- Só precisa do HTML? Requests resolve.

- Precisa clicar, rolar, preencher formulários ou logar? Use Selenium (simula ações humanas).

Qual é a escala do projeto?

- Tarefa pontual (uma ou poucas páginas): Requests ou Beautiful Soup;

- Milhares de páginas: Scrapy, que foi feito para crawlers em larga escala, com filas, paralelismo e pipelines.

O site tem bloqueios ou medidas anti-scraping?

Se há proxies, rotação de user-agents ou delays, você vai precisar de soluções mais robustas, como Selenium combinado a estratégias de bypass.

Como você vai usar os dados depois?

- Tabelas para análise: Pandas com read_html é o atalho mais prático;

- Armazenamento em banco de dados: frameworks como Scrapy ajudam a organizar a saída em pipelines.

Exemplos práticos de uso de bibliotecas de Python web scraping

Ainda tem dúvidas sobre qual biblioteca escolher para o seu projeto web scraping? Veja algumas situações em que elas podem ser utilizadas.

1. Coletando dados de uma página estática (Requests + Beautiful Soup)

Este código coleta os nomes de todos os produtos listados em uma página estática:

import requests

from bs4 import BeautifulSoup

url = "https://example.com/products"

response = requests.get(url)

soup = BeautifulSoup(response.text, "html.parser")

# Extrair nomes de produtos

products = soup.find_all("h2", class_="product-name")

for product in products:

print(product.text.strip())O que esse código mostra?

- Usa o Requests para acessar a página e baixar o HTML;

- O Beautiful Soup transforma o HTML em uma estrutura que o Python entende;

- O

find_allprocura todas as tags<h2>com a classeproduct-name; - O loop percorre cada produto encontrado e imprime o texto dentro da tag.

2. Navegando em um site dinâmico e extraindo dados (Selenium)

Este código simula o comportamento de um usuário em um site dinâmico, clicando para carregar mais itens e coletando os dados exibidos após a interação:

from selenium import webdriver

from selenium.webdriver.common.by import By

import time

driver = webdriver.Chrome()

driver.get("https://example.com")

# Clicar no botão "Carregar mais"

load_more = driver.find_element(By.ID, "load-more-btn")

load_more.click()

time.sleep(3) # aguarda carregamento

# Extrair itens da página

items = driver.find_elements(By.CLASS_NAME, "item-class")

for item in items:

print(item.text)

driver.quit()O que esse código mostra?

- Abre o navegador Chrome usando o Selenium;

- Acessa a URL indicada;

- Localiza o botão com ID

load-more-btne simula um clique; - Aguarda 3 segundos para que o conteúdo seja carregado;

- Busca todos os elementos com a classe

item-classe imprime o texto de cada um; - Fecha o navegador com

driver.quit().

3. Organizando os dados coletados em um DataFrame (integração com Pandas)

Este código mostra como organizar dados coletados em uma tabela e salvar em CSV para análise posterior:

import pandas as pd

# Dados simulados

data = {

"Produto": ["Notebook", "Smartphone", "Fone de Ouvido"],

"Preço": ["R$ 3.500", "R$ 2.000", "R$ 300"]

}

df = pd.DataFrame(data)

# Mostrar as primeiras linhas

print(df.head())

# Salvar em CSV

df.to_csv("produtos.csv", index=False)O que esse código mostra?

- Cria um dicionário com produtos e preços;

- Converte o dicionário em um DataFrame do Pandas, organizando os dados em formato tabular;

- Exibe as primeiras linhas com

df.head(); - Exporta a tabela para um arquivo CSV chamado

produtos.csv.

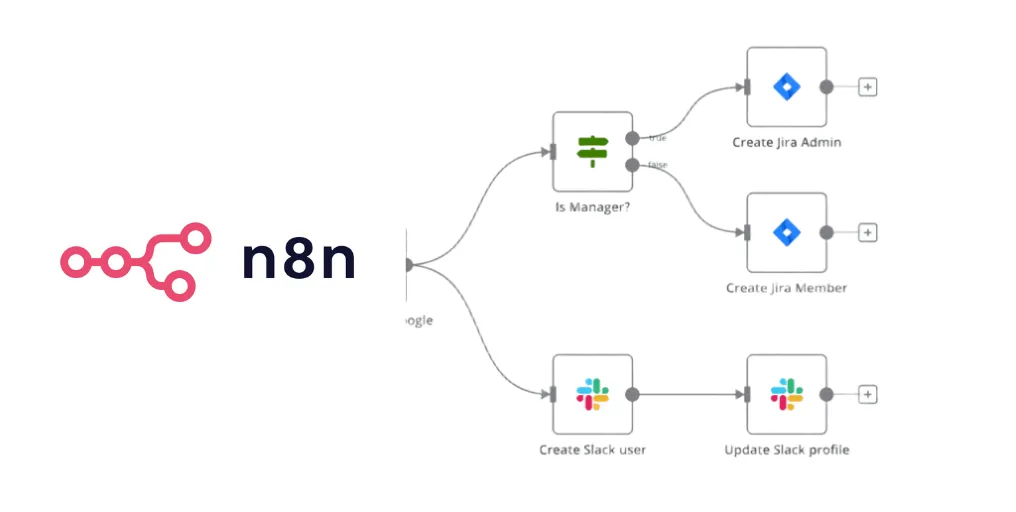

4. Pipeline híbrido para extração de dados

Este código mostra uma estratégia escalonada de scraping: começa pelas bibliotecas mais rápidas e simples e só usa o Selenium quando necessário:

import requests

import pandas as pd

from bs4 import BeautifulSoup

from selenium import webdriver

from selenium.webdriver.common.by import By

from selenium.webdriver.chrome.options import Options

import time

def pipeline_completo(url):

# 1. Requests para verificar se é site estático

try:

response = requests.get(url, timeout=10)

response.raise_for_status()

soup = BeautifulSoup(response.text, 'html.parser')

# 2. Pandas para tabelas rápidas

try:

tabelas = pd.read_html(response.text)

if len(tabelas) > 0:

return tabelas[0] # retorna a primeira tabela encontrada

except ValueError:

pass # nenhuma tabela válida encontrada

# 3. Beautiful Soup para HTML estático

dados = soup.find_all('div', class_='data-item')

if dados:

return [item.text.strip() for item in dados]

except requests.exceptions.RequestException as e:

print(f"Erro com Requests: {e}")

# 4. Selenium como último recurso (JS dinâmico)

chrome_options = Options()

chrome_options.add_argument("--headless")

driver = webdriver.Chrome(options=chrome_options)

try:

driver.get(url)

time.sleep(3)

elementos = driver.find_elements(By.CLASS_NAME, "dynamic-content")

return [elem.text for elem in elementos]

finally:

driver.quit()

# Uso do pipeline

dados = pipeline_completo("https://exemplo.com")

print(dados)O que esse código mostra?

- Requests: acessa o site e baixa o HTML;

- Pandas (read_html): se encontrar tabelas, converte direto em DataFrame;

- Beautiful Soup: se não houver tabelas, procura elementos com a classe data-item;

- Selenium: se nada funcionar, abre o navegador em modo headless e extrai o conteúdo dinâmico carregado via JavaScript.

Docstóteles (RAG + Web Scraping)

Como aprender Web Scraping com Python e automatizar a coleta de dados de qualquer site

O web scraping é uma das habilidades mais valorizadas no mercado de dados. Profissionais que dominam essa técnica conseguem:

- Automatizar a coleta de dados para análise competitiva;

- Monitorar preços e tendências de mercado em tempo real;

- Coletar dados públicos para pesquisa e tomada de decisão;

- Criar pipelines automatizados de coleta e processamento de dados.

Mas, para realmente dominar tudo isso, você precisa ir além das bibliotecas de Python web scraping.

No Curso Web Scraping e Automação com Python, da Asimov Academy, você aprende na prática como:

- Automatizar tarefas repetitivas;

- Extrair dados de sites de forma eficiente;

- Aplicar Python em projetos reais de scraping.

Esse curso faz parte da Trilha Python Office, ideal para quem quer aprender lógica de programação e Python do zero, mesmo sem experiência prévia.

Comece hoje a automatizar seu trabalho e transforme sua carreira!

Trilha Python Office

Automatize tudo com Python e torne seu escritório muito mais eficiente! Manipule arquivos, crie relatórios automatizados e construa sistemas 100% personalizados usando apenas Python.

Comece agora

Cursos de programação gratuitos com certificado

Aprenda a programar e desenvolva soluções para o seu trabalho com Python para alcançar novas oportunidades profissionais. Aqui na Asimov você encontra:

- Conteúdos gratuitos

- Projetos práticos

- Certificados

- +20 mil alunos e comunidade exclusiva

- Materiais didáticos e download de código

Comentários

30xpConsiderando as ótimas funcionalidades do playwright, imaginei que encontraria alguma trilha ou curso que ensinasse a automatizar processos (RPA) utilizando essa biblioteca.

Olá Luiz, por enquanto não temos um curso usando o Playwright, mas como Selenium sim.

Estamos organizando a lista para poder gravar mais cursos, o Playwright pode entrar em algum momento.

Agradeço a resposta.

Porém preciso deixar registrado que atualmente o playwright tem sido considerado bem mais eficiente que o selenium.

Seria uma oportunidade para vocês sairem na frente dos concorrentes. kkkkk