- Cursos

- Airflow na prática: ETL profissional com containers no Docker Compose

Sobre o curso

Airflow na prática: da arquitetura ao ETL completo do Aeroporto de Schiphol

O Apache Airflow é uma das ferramentas mais importantes para quem trabalha com engenharia e automação de dados. Ele coordena pipelines usados por empresas do mundo inteiro — e este curso vai mostrar a você, de forma clara e prática, como construir um pipeline real do zero usando a API oficial do Aeroporto de Schiphol.

Começamos entendendo os fundamentos do Airflow: como funciona a arquitetura interna (Scheduler, Webserver, Workers e Banco de Metadados), como as DAGs são interpretadas e por que o Airflow se tornou o padrão do mercado em orquestração. Em seguida, você configura todo o ambiente profissional usando Docker Compose e um DevContainer, garantindo que seu Airflow rode de forma previsível, isolada e igual ao que empresas utilizam em produção. Com o ambiente preparado, você cria suas primeiras DAGs simples — uma com BashOperator, outra com PythonOperator — até chegar em fluxos condicionais usando o BranchPythonOperator.

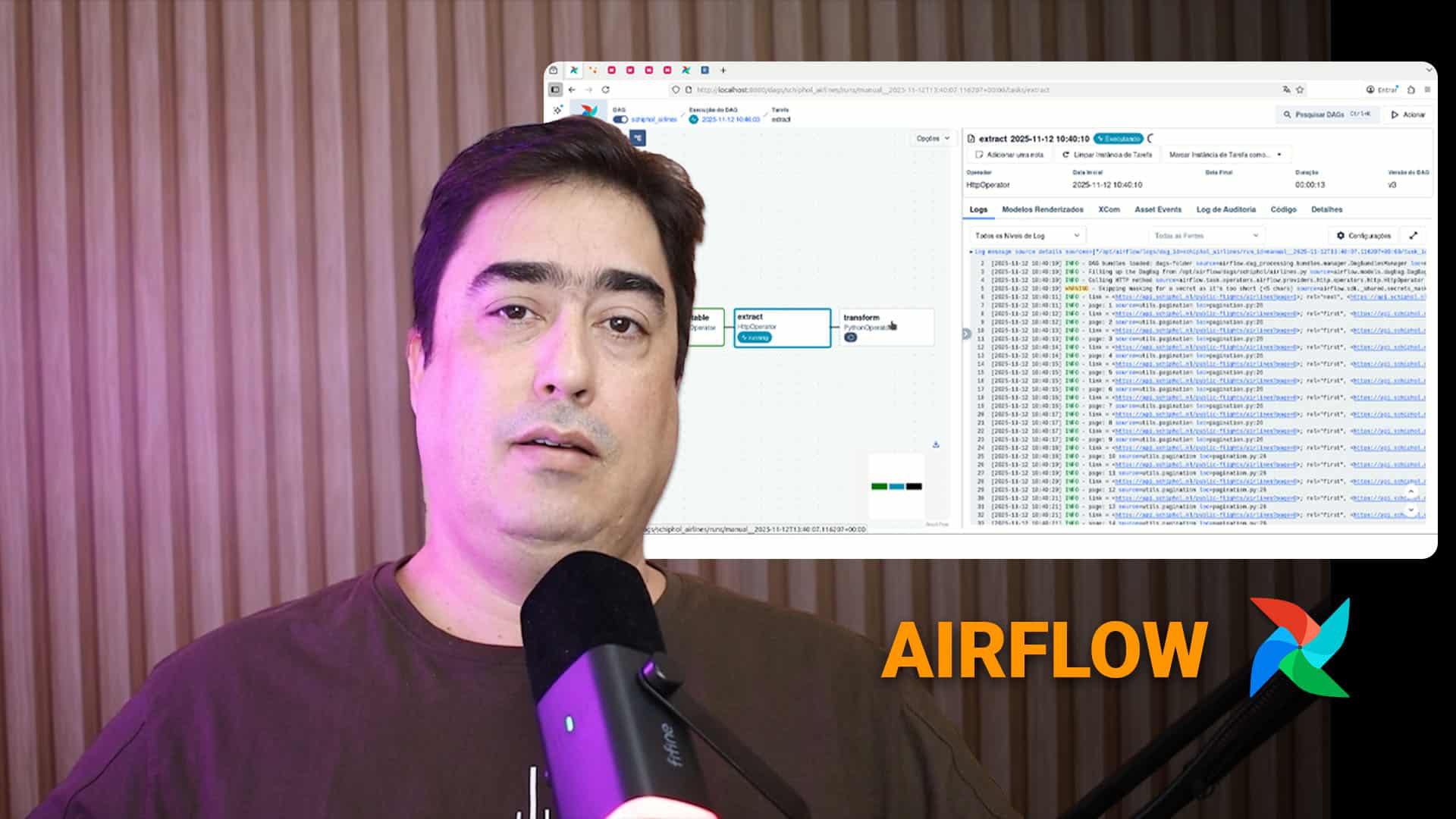

Esse aquecimento abre caminho para o projeto principal do curso. A partir daí, você inicia a construção de um projeto completo: um pipeline de ETL que coleta, transforma e carrega dados da API do Aeroporto de Schiphol. Esse pipeline — desenvolvido passo a passo ao longo de todo o curso — integra quatro grupos de dados: tipos de aeronaves, companhias aéreas, destinos e voos. Dentro desse projeto, você aprende a:

• Consumir endpoints reais com o HttpOperator, inclusive com paginação • Revisar e analisar a documentação da API

• Criar seu próprio banco de dados dedicado usando PotstgreSQL (Schiphol_DB) • Extrair dados brutos de cada endpoint (AircraftTypes, Airlines, Destinations e Flights)

• Realizar transformações estruturadas e incrementais

• Carregar tudo no banco de forma organizada e consistente

• Controlar dependências e ordem de execução das DAGs Ao final, você ainda ajusta elementos essenciais para pipelines profissionais: schedules, retries, delays.

O resultado é direto: você sai do curso entendendo a teoria do Airflow e, ao mesmo tempo, dominando a construção de um ETL completo, robusto e automatizado, rodando em ambiente Docker e baseado em uma API real — exatamente como acontece no dia a dia de engenharia de dados.

Este curso é recomendado para

- Alunos da trilha de Engenharia de Dados da Asimov Academy

- Pessoas que já programam em Python e querem dar o próximo passo

- Quem quer executar ETL de forma profissional

- Profissionais que querem melhorar processos de automação

Conteúdo do Curso

1 Airflow na Prática

2 DAGS e Operadores

3 DAGS do Aeroporto de Schiphol

O que você vai aprender

- Configurar o Airflow com Docker Compose e DevContainer.

- Criar e executar DAGs com BashOperator e PythonOperator.

- Consumir dados reais usando o HttpOperator e a API do Aeroporto de Schiphol.

- Criar e estruturar um banco de dados para armazenar dados da API.

- Realizar ETL completo: extrair, transformar e carregar dados.

- Ajustar schedules, retries e delays para pipelines robustos.

- Aplicar boas práticas na organização e manutenção de DAGs.