Se você busca uma forma eficiente e privada de desenvolver código com inteligência artificial, o DeepSeek no VS Code pode ser a solução ideal. Diferentemente de outras ferramentas de IA, ele permite gerar código e otimizar seu fluxo de trabalho completamente offline, garantindo mais segurança e privacidade.

Neste artigo, você aprenderá a instalar e configurar o DeepSeek no Visual Studio Code, explorando suas funcionalidades para aprimorar a produtividade no desenvolvimento com Python.

O que é o DeepSeek?

O DeepSeek é um modelo de linguagem de grande escala (LLM) criado na China, projetado para processamento de linguagem natural e geração de código. Lançado em 2023, ele foi treinado com um extenso conjunto de dados de código-fonte e documentação técnica, tornando-se altamente eficiente para auxiliar em tarefas de programação.

A DeepSeek AI, empresa responsável pelo modelo, busca tornar a inteligência artificial mais acessível e eficiente. O DeepSeek-R1, primeira versão otimizada para uso local, permite que desenvolvedores utilizem IA sem depender da nuvem.

Para saber mais sobre o que é o DeepSeek e como ele funciona, recomendamos a leitura do texto abaixo:

Vantagens de usar o DeepSeek no VS Code

- Privacidade: funciona 100% offline, seu código nunca sai do seu computador;

- Gratuidade: sem custos mensais ou anuais;

- Performance: resultados comparáveis a soluções pagas;

- Integração: perfeita harmonia com o VS Code.

Pré-requisitos para utilizar o DeepSeek no VS Code

Antes de começar a instalação, certifique-se de que seu sistema atende aos requisitos mínimos:

- Sistema operacional: Windows 10/11, macOS 10.15+ ou Linux;

- Memória RAM: mínimo 8GB (16GB recomendado);

- Espaço em disco: 2GB livres para o modelo mais leve;

- Python: versão 3.8 ou superior;

- VS Code: instalado.

Como instalar e configurar o VS Code no Windows

Passo a passo: instalando o Ollama, o DeepSeek-R1 e a extensão do VS Code

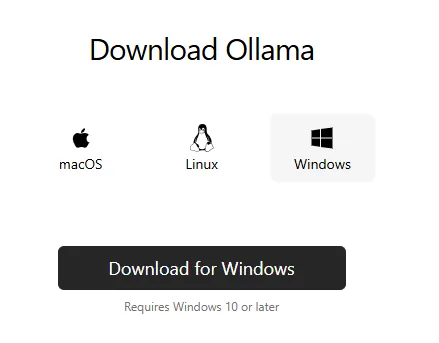

Para começar a usar o DeepSeek, precisamos configurar três componentes principais: o Ollama (que gerencia os modelos de IA), o modelo DeepSeek-R1 propriamente dito e a extensão do VS Code. O processo é simples e direto, mas deve ser feito na ordem correta para garantir o funcionamento adequado.Fonte: site Ollama

1. Instalando Ollama

Windows:

- Acesse o site oficial da Ollama;

- Baixe e execute o instalador .exe;

- Siga as instruções do assistente;

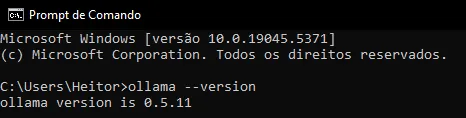

- Abra o terminal e execute: `ollama –version`.

macOS:

- Baixe o instalador .dmg do site oficial;

- Execute e siga as instruções;

- Verifique a instalação: `ollama –version`.

Linux:

- Abra o terminal e execute:

- `curl -fsSL https://ollama.com/install.sh | sh`

- Verifique a instalação: `ollama –version`.

2. Instalando o modelo DeepSeek

O DeepSeek-R1 oferece diferentes variações para atender a diferentes necessidades:

- 1.5b (1.1GB) – Ideal para laptops e máquinas com recursos limitados;

- 7b (4.7GB) – Bom equilíbrio entre performance e recursos;

- 8b (4.9GB) – Similar ao 7b com melhorias específicas;

- 14b (9.0GB) – Recomendado para máquinas mais potentes;

- 32b (20GB) – Para workstations;

- 70b (43GB) – Para servidores dedicados;

- 671b (404GB) – Uso empresarial.

Para iniciantes, recomendamos começar com o modelo 1.5b ou 7b:

- Abra o terminal;

- Execute o comando: `ollama pull deepseek-r1` ou use o comando de acordo com o modelo que você quer no site do Ollama;

- Aguarde o download (pode levar alguns minutos);

- Execute o comando: `/bye` para sair do Ollama.

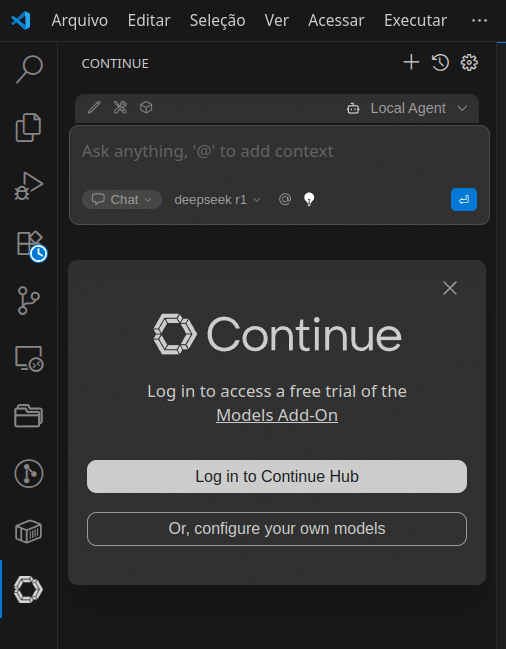

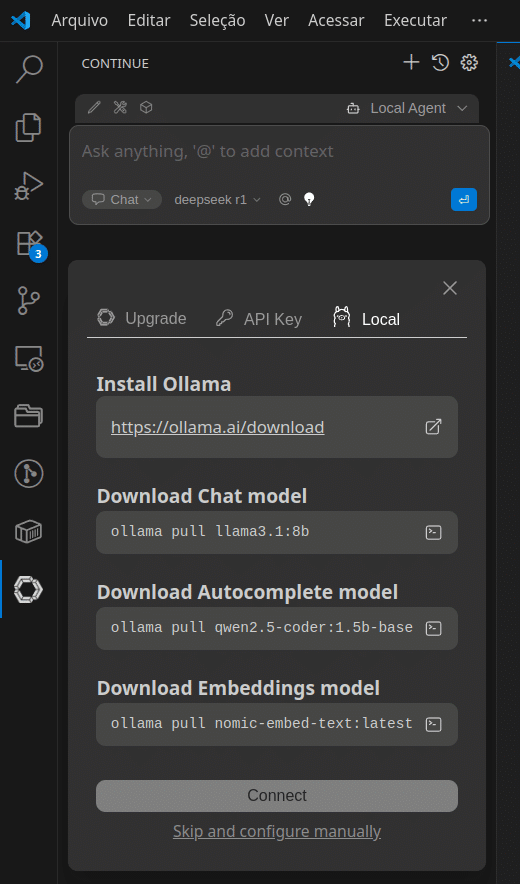

3. Configurando o VS Code

- Abra o VS Code;

- Instale a extensão “Continue – open-source AI code agent”;

- Reinicie o VS Code.

Temas do VS Code: conheça os 9 mais usados

Como usar o DeepSeek no VS Code

Após concluir a instalação do Ollama, do modelo DeepSeek e da extensão Continue, você está pronto para começar a usar a ferramenta. Então vamos ver como aproveitar ao máximo seus recursos.

Iniciando o serviço Ollama

Antes de começar a usar o DeepSeek, certifique-se de que o serviço Ollama está rodando:

- Abra um terminal;

- Execute o comando: `ollama serve`;

- Mantenha este terminal aberto enquanto estiver usando o DeepSeek.

NOTA: se der o erro `listen tcp 127.0.0.1:11434`, após uma nova instalação, você pode pular para a etapa de execução do modelo (pois o servidor Ollama já deve estar rodando na porta número 11434 após uma nova instalação).

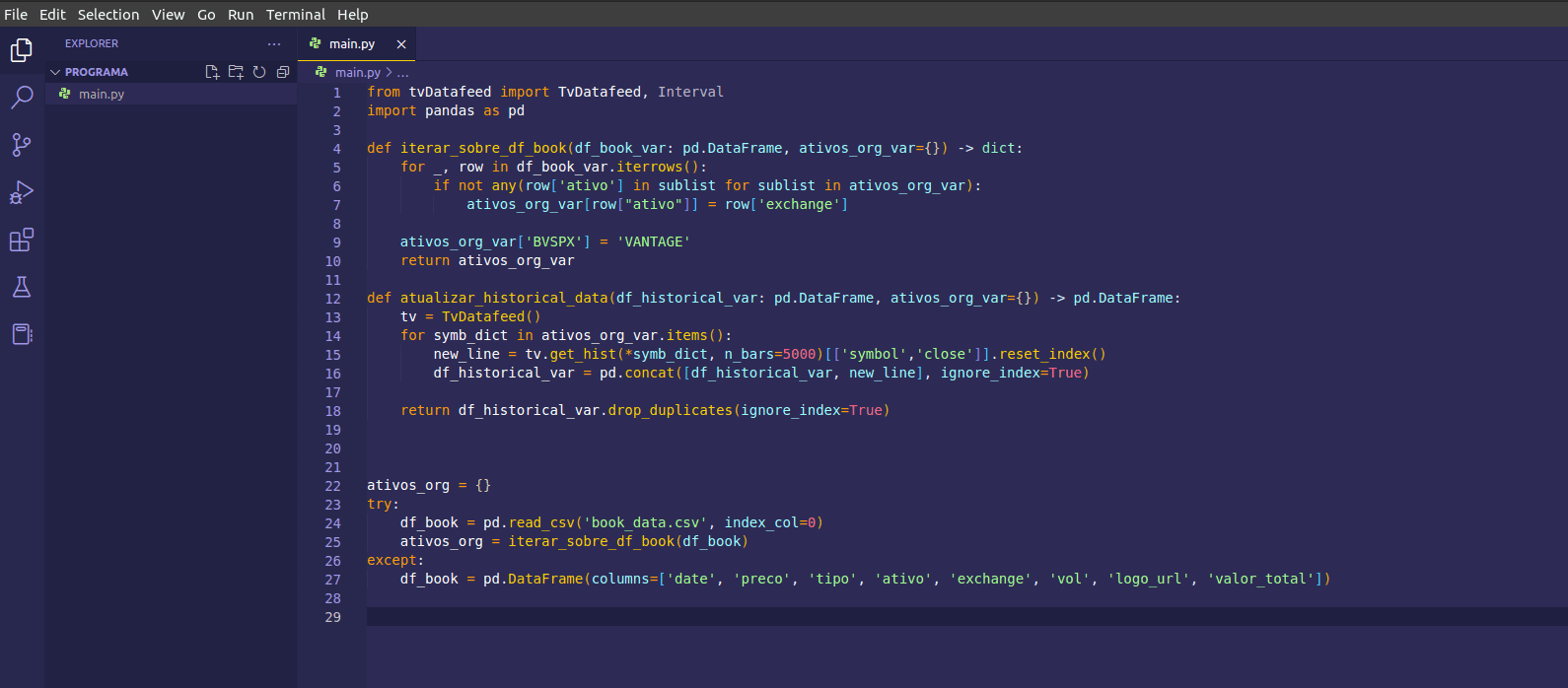

Preparando o ambiente VS Code

- Abra o VS Code;

- Crie ou abra um projeto Python;

- Abra a paleta de comandos (Ctrl+Shift+P ou Cmd+Shift+P no macOS);

- Digite “Continue: Focar no Modo de Exibição Continue” e pressione Enter;

- Escolha a opção “Or, configure your own models”

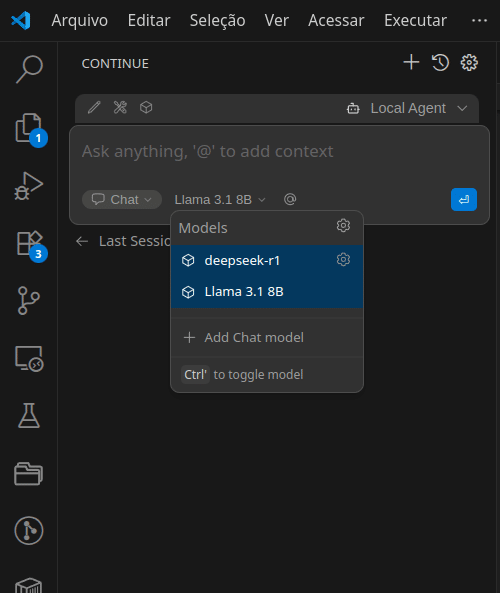

Utilizando o DeepSeek no VS Code: chat e sugestões de código

Selecione o modelo “deepseek-r1” na lista que aparecer.

No chat, você pode:

- Fazer perguntas sobre seu código;

- Solicitar explicações sobre funções;

- Pedir sugestões de melhorias;

- Requisitar documentação.

Através de comentários

No seu arquivo Python:

- Digite `#` ou `”””` para iniciar um comentário;

- Escreva sua pergunta ou solicitação;

- Pressione Enter.

Então, o DeepSeek irá:

- Analisar seu comentário;

- Gerar sugestões relevantes;

- Oferecer completions de código.

Tipos de interações suportadas

1. Complemento de código

- Digite parte do código;

- Pressione Tab para ver sugestões;

- Use as setas para navegar entre as opções.

2. Explicações de código

- Selecione um trecho de código;

- Clique com o botão direito;

- Escolha “Explain Code” no menu contextual.

3. Documentação

- Posicione o cursor sobre uma função;

- Digite `”””` e pressione `Enter`;

- O DeepSeek gerará uma docstring apropriada.

Dicas para melhores resultados

1. Seja específico

- Use termos técnicos precisos;

- Forneça contexto relevante;

- Explique o resultado desejado.

2. Mantenha o contexto

- Mantenha arquivos relacionados abertos;

- Referencie funções e variáveis existentes;

- Mencione bibliotecas que está usando.

3. Iteração

- Comece com pedidos simples;

- Refine gradualmente suas solicitações;

- Use o feedback do modelo para melhorar seus prompts.

Recursos de produtividade

1. Atalhos úteis

- `Ctrl + /` (`Cmd + /` no macOS): inicia um comentário;

- `Ctrl + Space`: força sugestões de código;

- `Ctrl + Shift + A`: abre o chat do Cody.

2. Comandos da paleta

- “Cody: Reset Chat”: limpa o histórico de chat;

- “Cody: Restart Language Server”: resolve problemas de conexão;

- “Cody: Configure Settings”: ajusta preferências.

Quando reiniciar o serviço Ollama

É recomendado reiniciar o serviço Ollama quando:

- O VS Code não está recebendo sugestões;

- As respostas estão muito lentas;

- Após atualizações do sistema;

- Se houver erros de conexão.

Para reiniciar:

- Feche o terminal com `ollama serve`;

- Abra um novo terminal;

- Execute `ollama serve` novamente;

Solução de problemas: erros comuns e como resolvê-los

Ollama não responde

Problema: serviço não responde na porta 11434.

Solução:

- Verifique se o serviço está rodando;

- Execute no terminal: `ollama serve`.

Erro no download

Problema: falha ao baixar modelos.

Solução:

- Verifique sua conexão;

- Certifique-se de ter espaço suficiente;

- Tente novamente com ollama pull deepseek-r1.

Segurança e privacidade do DeepSeek

O DeepSeek oferece vantagens significativas em termos de segurança:

- Todo processamento é local;

- Nenhum dado é enviado para servidores externos;

- Conformidade com políticas de segurança empresariais;

- Proteção de propriedade intelectual.

Comparativo: DeepSeek vs. outras IAs de código

| Recurso | DeepSeek | GitHub Copilot | Tabnine | CodeFonton |

| Uso offline | ✅ | ❌ | ⚠️ | ✅ |

| Custo | Gratuito | $10/mês | Freemium | Gratuito |

| Suporte a Python | Excelente | Excelente | Bom | Bom |

| Velocidade | Boa | Excelente | Boa | Média |

| Precisão | Muito Boa | Excelente | Boa | Boa |

| Recursos offline | Completos | Nenhum | Limitados | Completos |

Conclusão

O DeepSeek representa uma evolução significativa no desenvolvimento Python, oferecendo uma alternativa gratuita e offline ao GitHub Copilot. Com sua instalação simples, variedade de modelos e capacidade de gerar código de qualidade, torna-se uma ferramenta indispensável para desenvolvedores que valorizam privacidade e eficiência.

Para complementar seus estudos sobre o teman, confira nossos tutoriais específicos sobre como rodar modelos de linguagem natural localmente com Ollama e como utilizar Ollama via LangChain:

Rodando Modelos de Linguagem Natural Localmente com Ollama

Como Utilizar Ollama via LangChain: Um Guia para Iniciantes

Além disso, se deseja continuar sua jornada de aprendizado e aprofundar seus conhecimentos em IA e desenvolvimento Python, recomendamos acessar o curso gratuito de IA da Asimov Academy, que ajudará você a levar suas habilidades ao próximo nível.

Seu primeiro projeto de IA com Python – curso grátis com certificado

Aprenda a programar com Python e explore a inteligência artificial! Crie um chatbot prático que interage com seus próprios dados.

Comece agoraCom esses recursos e o DeepSeek em mãos, você está bem equipado para começar sua jornada no desenvolvimento Python assistido por IA.

Cursos de programação gratuitos com certificado

Aprenda a programar e desenvolva soluções para o seu trabalho com Python para alcançar novas oportunidades profissionais. Aqui na Asimov você encontra:

- Conteúdos gratuitos

- Projetos práticos

- Certificados

- +20 mil alunos e comunidade exclusiva

- Materiais didáticos e download de código

Comentários

30xplá,

No passo 4, do 'Seguindo Preparando o ambiente VS Code, solicita para entrar na Sourcegraph:

Esqueci algo ou a extensão sofreu uma atualização?

Olá Emanoel, a imagem não apareceu.

Aqui tem que usar o ícone de imagem da caixa de texto, Ctrl + C e Ctrl + V de imagem não funciona.

Aguardo sua resposta.

Olá, Heitor, no passo indicado é solicitado para realizar um cadastro no Sourcegraph. Acredito que a aula precisa de atualização, pois a extensão indicada agora solicita essa etapa, obrigatoriamente. Parei por isso.

Obrigado por avisar Emanoel, vou marcar aqui.

Qualquer dúvida estamos à disposição!

Atualizando: cody free não está mais disponível desde 25 de julho deste ano.

Sim, estou vendo se dá para instalar a versão antiga, mas aparentemente não dá. Vamos atualizar de acordo com as opções atuais vlw por avisar!

Olá Emanoel! Já está atualizado agora com outra extensão.

Precisando de ajuda estou por aqui!

O passo a passo para usar com outras finalidades, que não apenas programação seria o mesmo?

Olá Valber. Sim, continua o mesmo.

Esse processo está utilizando o VS Code, mas existem outras ferramentas que "imitam" o ChatGPT usando outra I.A.

No entanto, é o mesmo que usar a barra lateral do VS Code.

Se ficar alguma dúvida pode mandar por aqui!

Boa, Matheus! O DeepSeek 8B é realmente uma ótima opção para rodar localmente, ainda mais para quem busca autonomia sem depender de APIs pagas. Ele tem um bom equilíbrio entre desempenho e eficiência, especialmente para tarefas de programação.

Se tiver alguma dúvida em relação a esse assunto pode mandar mandar! 🚀