Ética na inteligência artificial (IA) é o conjunto de princípios e práticas que orientam o uso justo, seguro e transparente de sistemas inteligentes. Ou seja, é o que garante que uma tecnologia tão avançada seja aplicada para gerar benefícios sem colocar pessoas ou a sociedade em risco.

Esse campo ganhou força porque, mesmo sem intenção, algoritmos podem tomar decisões discriminatórias, invadir a privacidade ou reforçar preconceitos já existentes nos dados.

Pense em áreas como trabalho, educação e saúde, por exemplo. Quando a IA é aplicada sem critérios éticos, o impacto pode ser negativo e de grande alcance.

Por isso, a ética em IA não é só um tema filosófico. Ela também envolve aspectos:

- Técnicos: curadoria e qualidade dos dados usados no treinamento;

- Legais: respeito à privacidade e à segurança;

- Sociais: avaliação das consequências de cada aplicação.

Principais dilemas éticos envolvendo a IA

O lançamento do ChatGPT, em 2022, mostrou o poder da IA generativa para escrever textos, analisar códigos e até apoiar decisões complexas. Isso só foi possível graças aos modelos de base, enormes redes treinadas com bilhões de dados da internet.

Mas, junto às possibilidades, vieram também dilemas envolvendo a ética na inteligência artificial. Conheça os principais a seguir:

Viés algorítmico

O viés algorítmico é o dilema mais conhecido. Se os dados usados no treinamento refletem preconceitos já existentes na sociedade, a IA tende a reproduzir e ampliar esses padrões. Como esses sistemas tomam decisões em escala, os impactos podem ser multiplicados e gerar injustiças.

A Amazon já enfrentou problemas por conta desse tipo de viés. Ela desenvolveu uma IA para triagem de currículos, mas teve que abandonar o projeto. Isso porque o modelo aprendeu com dados históricos que favoreciam homens em cargos técnicos e passou a rejeitar candidatas mulheres qualificadas.

Esse problema também pode ocorrer em algoritmos de reconhecimento facial (que apresentam maior taxa de erro para pessoas negras) e em ferramentas de crédito (que podem excluir populações inteiras do acesso a serviços), por exemplo.

Falta de transparência e explicabilidade

Muitos modelos de IA funcionam como “caixas-pretas”, ou seja, entregam respostas sem deixar claro como chegaram até elas. Isso cria problemas sérios em setores como saúde e finanças, em que muitas decisões precisam ser justificadas.

Vamos supor que uma IA negue um empréstimo bancário ao cliente de um banco. Se o cliente perguntar o motivo, mas o sistema não oferecer explicações claras, a instituição fica em uma situação delicada. Sem transparência, é difícil construir confiança entre usuários e empresas.

Privacidade e uso de dados

A inteligência artificial precisa de grandes volumes de dados para aprender e gerar resultados. O problema é que muitos desses dados são pessoais e sensíveis, o que abre espaço para violação de privacidade, vazamentos e vigilância em massa.

Esse é um dos dilemas mais urgentes relacionados ao tema, já que a confiança do usuário depende diretamente de como seus dados são tratados.

Desemprego tecnológico

Será que a IA vai roubar seu emprego? Essa é uma das dúvidas mais comuns quando se fala em inteligência artificial.

De fato, a tecnologia já está transformando o mercado de trabalho. Funções repetitivas tendem a ser automatizadas, enquanto surgem novas oportunidades em áreas como análise de dados, desenvolvimento e manutenção de sistemas inteligentes.

Nesse contexto, o desafio ético é garantir que essa transição não deixe milhares de pessoas para trás. Profissionais cujas tarefas foram automatizadas precisam ter a chance de se requalificar para novas funções.

E isso exige políticas de educação, treinamento e adaptação, garantindo que o progresso tecnológico não aumente ainda mais as desigualdades sociais.

IA no mercado de trabalho: ameaça ou aliada para sua carreira?

Prestação de contas

Quem deve ser responsabilizado quando a IA gera um erro ou causa danos? Essa é uma questão ainda sem resposta unânime. Alguns países já avançam em legislações específicas, mas a falta de clareza sobre responsabilidade ainda predomina.

A complexidade dos sistemas torna o dilema ainda maior. Muitas decisões resultam de várias camadas de algoritmos e dados, dificultando identificar onde a falha ocorreu. Isso pode gerar situações em que ninguém assume a culpa, deixando usuários e afetados desamparados.

Singularidade tecnológica

A singularidade tecnológica é uma hipótese segundo a qual a IA poderia, no futuro, ultrapassar a inteligência humana e evoluir de forma autônoma. Embora esse cenário ainda esteja distante, ele já levanta discussões éticas sobre controle e responsabilidade.

O uso de carros autônomos exemplifica essa discussão. Eles não têm consciência, mas precisam tomar decisões críticas em frações de segundo. Ainda assim, é impossível garantir que acidentes nunca aconteçam.

E, quando ocorrerem, surge a pergunta: quem deve ser responsabilizado? O programador, a montadora, o dono do carro ou o próprio sistema? Esse tipo de debate mostra a complexidade do problema e a urgência de regras claras sobre o assunto.

O que são agentes de inteligência artificial?

Princípios fundamentais de uma IA ética

Diante de tantos dilemas, você pode estar se perguntando: como garantir que a IA seja usada de forma justa, segura e responsável?

Ainda não temos respostas definitivas para todas as questões, mas já existe um consenso: a IA precisa seguir alguns princípios que funcionam como guia para programadores, empresas e usuários.

Conheça esses princípios da ética na inteligência artificial a seguir:

- Respeito pelas pessoas: isso significa garantir o consentimento informado. O usuário precisa saber quais dados estão sendo coletados, como serão usados e quais riscos existem no processo;

- Beneficência: inspirado na ética médica, esse princípio pode ser resumido em: não causar dano. Na IA, isso significa evitar algoritmos que reforcem preconceitos, discriminem grupos sociais ou gerem consequências negativas;

- Justiça: garante imparcialidade e igualdade de tratamento. Um sistema de IA ético deve evitar e mitigar vieses injustos relacionados à etnia, gênero, idade, orientação sexual, religião ou qualquer outro atributo;

- Transparência: a confiança só existe quando as decisões da IA podem ser explicadas. Por isso, sistemas de IA não podem ser “caixas-pretas”. Eles devem garantir que suas decisões sejam compreensíveis e auditáveis por seres humanos;

- Responsabilidade: sempre deve haver alguém responsável pelas ações da IA. Seja desenvolvedor ou empresa, esse princípio garante clareza sobre quem responde em caso de falhas ou danos;

- Segurança: a IA precisa ser confiável. Isso significa, além de funcionar bem em condições ideais, ela precisa resistir a falhas, ataques maliciosos e cenários inesperados;

- Privacidade: a IA depende de dados, mas isso não significa que tudo pode ser coletado. É preciso usar informações pessoais de forma responsável e transparente.

Tendências e inovações em inteligência artificial: panorama 2025

IA precisa de regulação?

Sim. Esse é o entendimento global sobre o tema. O debate hoje não é se devemos regular, mas como criar regras que incentivem a inovação sem deixar de proteger direitos fundamentais.

Para incentivar a criação de políticas nesse sentido, em 2021, a UNESCO publicou a Recomendação sobre a Ética da Inteligência Artificial, o primeiro instrumento global para orientar governos e empresas.

Em 2024, a União Europeia publicou o Regulamento Europeu da Inteligência Artificial (AI Act), a primeira legislação para o desenvolvimento e uso de IA no bloco. O objetivo é garantir que os sistemas sejam aplicados de forma segura e ética, protegendo os direitos dos cidadãos.

No Brasil, iniciativas como a Estratégia Brasileira de Inteligência Artificial (EBIA) e o Projeto de Lei 2338/23 buscam definir princípios, direitos e deveres para garantir o uso responsável da tecnologia.

Por enquanto, a legislação nacional mais importante sobre esse tema é a Lei Geral de Proteção de Dados Pessoais (LGPD), que trata da proteção de dados. Segundo o texto, qualquer tratamento de dados pessoais, desde o envio de um e-mail até o uso de APIs generativas como ChatGPT, está sujeito à lei.

Isso significa que programadores e empresas que usam Python e IA, por exemplo, precisam adotar práticas como manter registros de tratamento, realizar avaliações de impacto, garantir direitos dos titulares e investir em segurança.

LGPD e Inteligência Artificial: o que programadores precisam saber

O papel dos programadores e cientistas de dados na construção de uma IA ética

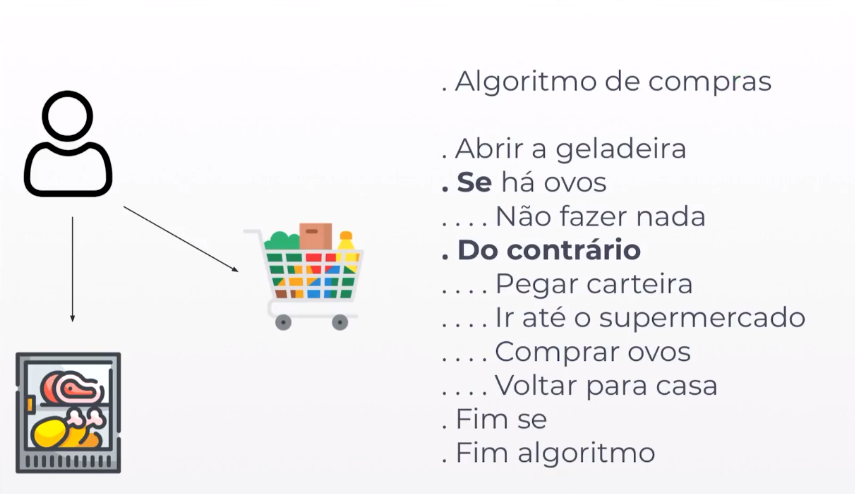

Na IA, cada escolha técnica também é uma decisão ética, desde quais dados coletar até como treinar e monitorar um modelo.

Isso significa que profissionais de tecnologia, engenheiros, analistas ou cientistas de dados, têm responsabilidade direta em garantir que os sistemas respeitem princípios de justiça, privacidade, transparência e segurança.

Na prática, isso envolve:

- Cuidar da qualidade e diversidade dos dados, evitando que vieses sejam reproduzidos em escala;

- Aplicar auditorias e técnicas de explicabilidade, para que decisões sejam compreensíveis;

- Fazer o monitoramento contínuo, garantindo que o sistema permaneça justo e confiável ao longo do tempo.

Ou seja, além de focar no desempenho dos modelos, esses profissionais precisam considerar as consequências sociais de suas aplicações. Esses aspectos também devem orientar o desenvolvimento de modelos de IA.

Como aplicar a ética na prática com Python e IA

A ética na inteligência artificial não deve ser encarada com um “módulo extra” que entra no final do projeto. Ela precisa estar presente em todas as etapas do ciclo de desenvolvimento, da concepção ao deploy e monitoramento.

Entenda como aplicar esses princípios nas principais etapas do seu projeto:

Coleta de dados

Nesta fase, você deve garantir que as amostras representem bem os grupos afetados pelo sistema. Para isso, use bibliotecas como Pandas e Matplotlib para analisar distribuições por sexo, raça, região ou idade.

Você também deve obter o consentimento dos usuários. Para isso, registre logs de consentimento que incluam data, finalidade e base legal da coleta. Além disso, centralize essas políticas em arquivos de referência, como data_policy.yaml, para padronizar e auditar o processo.

Bibliotecas Python: descubra o que são e como utilizá-las

Treinamento e desenvolvimento

Nas fases de treinamento e desenvolvimento de modelos, além de métricas tradicionais, como acurácia, você também deve avaliar indicadores de equidade. Para isso, use bibliotecas como Fairlearn (MetricFrame) ou AIF360.

Além disso, use técnicas como SHAP e LIME para entender quais variáveis influenciam mais as previsões do modelo, oferecendo relatórios que ajudam a auditar e corrigir problemas.

E não se esqueça de mitigar vieses em diferentes fases. Para isso, ajuste os dados de entrada, aplique restrições durante o treinamento ou calibre a saída do modelo, sempre registrando os resultados antes e depois para comprovar a melhoria.

Implementação

A implementação ética de IA exige monitoramento contínuo do desempenho e da justiça dos modelos, já que os dados mudam com o tempo. Isso pode ser feito acompanhando métricas de deriva de dados e desempenho, com bibliotecas como Evidently ou ferramentas de monitoramento em pipelines de dados.

Além disso, crie alertas automáticos e processos de investigação, retreinamento e validação, para corrigir erros antes que gerem grandes impactos. Assim, pequenos erros são corrigidos antes de gerar impactos maiores para usuários ou empresas.

Governança e boas práticas

A governança e as boas práticas são o que garantem transparência e confiança em todo o ciclo de vida da IA. Para isso, siga as seguintes orientações:

- Documente tudo: objetivos, dados, riscos, versões e métricas;

- Gere relatórios claros e acessíveis para usuários;

- Crie canais de contestação, comitês de revisão e checklists antes do deploy;

- Mantenha políticas que reforcem responsabilidade, transparência e conformidade legal.

Como começar a construir aplicações de IA com responsabilidade e domínio técnico?

A base para qualquer aplicação de IA ética e robusta é ter domínio sólido dos fundamentos. Afinal, não dá para auditar vieses ou garantir a justiça de um algoritmo sem antes entender a linguagem que dá vida a esses sistemas.

Por isso, o primeiro passo para se tornar um profissional de IA responsável é dominar Python, a linguagem mais simples e acessível para começar nessa área.

Se você quer dar seus primeiros passos em inteligência artificial já aplicando boas práticas de ética e responsabilidade, conheça o curso gratuito Python para IA, da Asimov Academy.

Nesse curso, você vai aprender Python do zero e ainda construir seu primeiro chatbot.

Inscreva-se agora e comece a aprender a usar IA de forma ética e prática!

Seu primeiro projeto de IA com Python – curso grátis com certificado

Aprenda a programar com Python e explore a inteligência artificial! Crie um chatbot prático que interage com seus próprios dados.

Comece agora

Cursos de programação gratuitos com certificado

Aprenda a programar e desenvolva soluções para o seu trabalho com Python para alcançar novas oportunidades profissionais. Aqui na Asimov você encontra:

- Conteúdos gratuitos

- Projetos práticos

- Certificados

- +20 mil alunos e comunidade exclusiva

- Materiais didáticos e download de código

Comentários

30xp